@observe() 装饰器](https://langfuse.com/docs/sdk/python/decorators) 可轻松跟踪任何 Python LLM 应用。在本快速入门中,我们还使用了 Langfuse 的 [OpenAI 集成](https://langfuse.com/integrations/model-providers/openai-py) 来自动捕获所有模型参数。

> [!提示]

> 不使用 OpenAI?请访问 [我们的文档](https://langfuse.com/docs/get-started#log-your-first-llm-call-to-langfuse) 了解如何记录其他模型和框架。

安装依赖:

```bash

pip install langfuse openai

```

配置环境变量(创建名为 **.env** 的文件):

```bash:.env

LANGFUSE_SECRET_KEY="sk-lf-..."

LANGFUSE_PUBLIC_KEY="pk-lf-..."

LANGFUSE_HOST="https://cloud.langfuse.com" # 🇪🇺 欧盟区域

# LANGFUSE_HOST="https://us.cloud.langfuse.com" # 🇺🇸 美洲区域

```

创建示例代码(文件名:**main.py**):

```python:main.py

from langfuse import observe

from langfuse.openai import openai # OpenAI 集成

@observe()

def story():

return openai.chat.completions.create(

model="gpt-4o",

messages=[{"role": "user", "content": "What is Langfuse?"}],

).choices[0].message.content

@observe()

def main():

return story()

main()

```

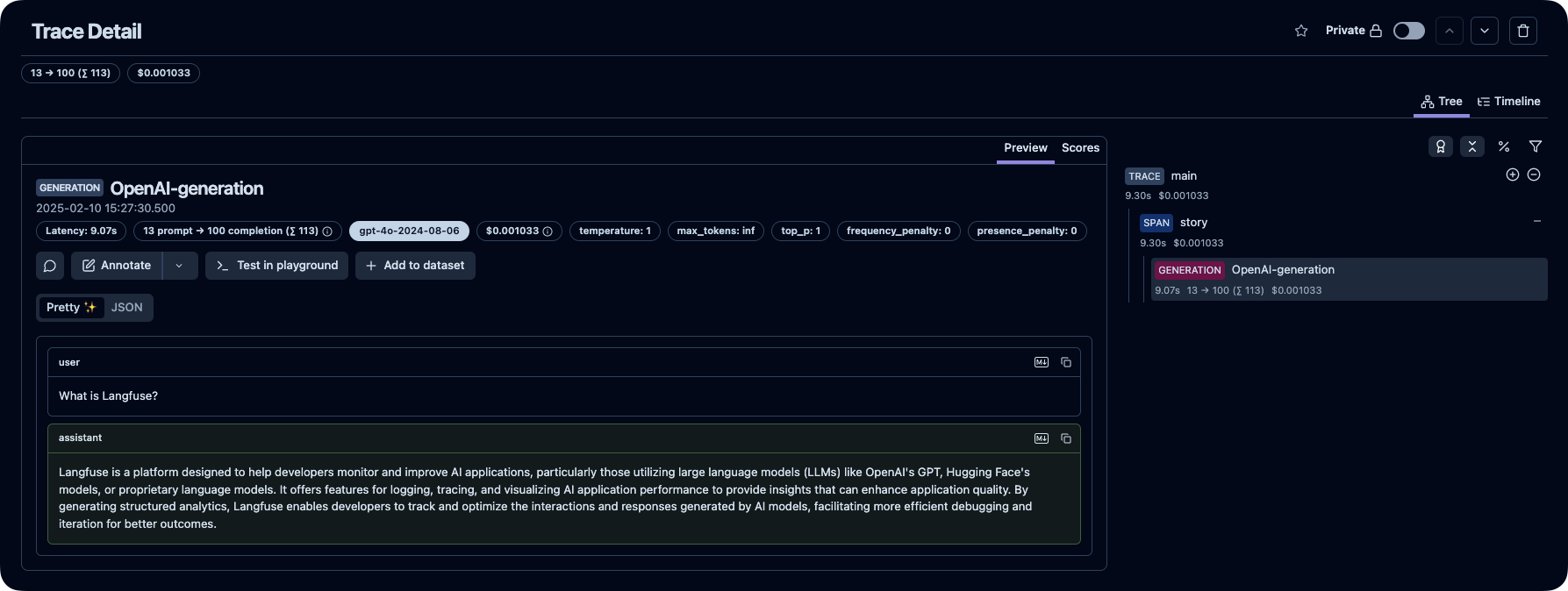

### 3️⃣ 在 Langfuse 中查看追踪记录

在 Langfuse 中查看你的语言模型调用及其他应用逻辑。

_[Langfuse 中的公共示例追踪](https://cloud.langfuse.com/project/cloramnkj0002jz088vzn1ja4/traces/2cec01e3-3dc2-472f-afcf-3b968cf0c1f4?timestamp=2025-02-10T14%3A27%3A30.275Z&observation=cb5ff844-07ef-41e6-b8e2-6c64344bc13b)_

> [!提示]

>

> [了解更多](https://langfuse.com/docs/tracing) 关于 Langfuse 中的追踪,或试试 [互动演示](https://langfuse.com/docs/demo)。

## ⭐️ 给我们加星

## 💭 支持

查找问题答案:

- 我们的 [文档](https://langfuse.com/docs) 是查找答案的最佳起点。内容全面,我们投入大量时间进行维护。你也可以通过 GitHub 提出文档修改建议。

- [Langfuse 常见问题](https://langfuse.com/faq) 解答了最常见的问题。

- 使用 "Ask AI" 立即获取问题答案。

支持渠道:

- **在 GitHub Discussions 的 [公共问答](https://github.com/orgs/langfuse/discussions/categories/support) 中提出任何问题。** 请尽量提供详细信息(如代码片段、截图、背景信息)以帮助我们理解你的问题。

- 在 GitHub Discussions 中 [提出功能请求](https://github.com/orgs/langfuse/discussions/categories/ideas)。

- 在 GitHub Issues 中 [报告 Bug](https://github.com/langfuse/langfuse/issues)。

- 对于时效性较强的问题,请通过应用内聊天小部件联系我们。

## 🤝 贡献

欢迎你的贡献!

- 在 GitHub Discussions 中为 [想法](https://github.com/orgs/langfuse/discussions/categories/ideas)投票。

- 提出并评论 [问题](https://github.com/langfuse/langfuse/issues)。

- 提交 PR —— 详情请参见 [CONTRIBUTING.md](CONTRIBUTING.md),了解如何搭建开发环境。

## 🥇 许可证

除 `ee` 文件夹外,本仓库采用 MIT 许可证。详情请参见 [LICENSE](LICENSE) 以及 [文档](https://langfuse.com/docs/open-source)。

## ⭐️ 星标历史