diff --git a/product/en/docs-uqbar/v2.0/toc.md b/product/en/docs-uqbar/v2.0/toc.md

new file mode 100644

index 0000000000000000000000000000000000000000..e3a8c5aba681d451dc343f5a60e14f0ce993eaa8

--- /dev/null

+++ b/product/en/docs-uqbar/v2.0/toc.md

@@ -0,0 +1,65 @@

+

+

+

+# Uqbar Documentation 2.0.0

+

+## Documentation List

+

++ [About Uqbar](/overview.md)

++ [Release Note](/release-notes/release-note.md)

+ + [Uqbar 2.0.0](./release-notes/2.0.0.md)

++ [Uqbar Installation](/ptk-based-installation.md)

++ [Uqbar Management](/uqbar-management.md)

++ [Data Retention Policy](./retention-policy.md)

++ [Time-Series Table Management](/time-series-table-management.md)

++ [Time-Series Data Write](/data-write/data-write-introduction.md)

+ + [Time-Series Data Write Method](/data-write/data-writing-method/data-writing-method.md)

+ + [Using SQL Statements to Write Data](/data-write/data-writing-method/SQL-supported-for-importing-data-to-table.md)

+ + [Using Drivers to Write Data](/data-write/data-writing-method/driver-supported-for-importing-data-to-table.md)

+ + [Using Kafka to Write Data](/data-write/data-writing-method/Kafka-supported-for-importing-data-to-table.md)

+ + [Time-Series Data Write Model](/data-write/data-writing-model/data-writing-model.md)

+ + [Single-Field and Multi-Field Model](/data-write/data-writing-model/single-field-and-multiple-field-model.md)

+ + [Data Imported Out of Order](/data-write/data-writing-model/data-imported-out-of-order.md)

+ + [Data Imported Without the Time Field](/data-write/data-writing-model/data-imported-without-the-time-field.md)

++ [Data Compression](/data-compression.md)

++ [Data Deletion](/expired-deletion.md)

++ [Data Query](./query-data/query-data.md)

+ + [Aggregation Operator](./query-data/aggregation-operator/aggregation-operator.md)

+ + [time_bucket()](./query-data/aggregation-operator/time-bucket.md)

+ + [time_bucket_gapfill()](./query-data/aggregation-operator/time-bucket-gapfill.md)

+ + [histogram()](./query-data/aggregation-operator/histogram.md)

+ + [Selection Operator](./query-data/selection-operator/selection-operator.md)

+ + [first()/last()](./query-data/selection-operator/first-last.md)

+ + [Conversion Operator](./query-data/conversion-operator.md)

+ + [Join Query](./query-data/join-query.md)

+ + [LATERAL Keyword](./query-data/lateral-keyword.md)

+ + [Index](./query-data/index.md)

++ [Continuous Aggregation](./continuous-aggregation.md)

++ [Time-Series Views](/timeseries-views/timeseries-views.md)

+ + [timeseries_views.bgw_job](/timeseries-views/timeseries_views.bgw_job.md)

+ + [timeseries_views.compression_chunkgroup](/timeseries-views/timeseries_views.compression_chunkgroup.md)

+ + [timeseries_views.compression_table](/timeseries-views/timeseries_views.compression_table.md)

+ + [timeseries_views.continuous_aggregation](/timeseries-views/timeseries_views.continuous_aggregation.md)

+ + [timeseries_views.policies](/timeseries-views/timeseries_views.policies.md)

+ + [timeseries_views.tschunkgroup](/timeseries-views/timeseries_views.tschunkgroup.md)

+ + [timeseries_views.tstable](/timeseries-views/timeseries_views.tstable.md)

++ [Cluster Management](/cluster-management.md)

++ [Backup and Restoration](/backup-restore.md)

++ [Security](/security.md)

++ [GUC Parameters](/guc-parameters.md)

++ [SQL Syntax](/uqbar-sql-syntax/uqbar-sql-syntax.md)

+ + [ALTER CONTINUOUS AGGREGATION](/uqbar-sql-syntax/ALTER-CONTINUOUS-AGGREGATION.md)

+ + [ALTER TIMESERIES POLICY](/uqbar-sql-syntax/ALTER-TIMESERIES-POLICY.md)

+ + [ALTER TIMESERIES TABLE](/uqbar-sql-syntax/ALTER-TIMESERIES-TABLE.md)

+ + [COMPRESS TIMESERIES](/uqbar-sql-syntax/COMPRESS-TIMESERIES.md)

+ + [CREATE CONTINUOUS AGGREGATION](./uqbar-sql-syntax/CREATE-CONTINUOUS-AGGREGATION.md)

+ + [CREATE TIMESERIES POLICY](/uqbar-sql-syntax/CREATE-TIMESERIES-POLICY.md)

+ + [CREATE TIMESERIES TABLE](/uqbar-sql-syntax/CREATE-TIMESERIES-TABLE.md)

+ + [DROP CONTINUOUS AGGREGATION](./uqbar-sql-syntax/DROP-CONTINUOUS-AGGREGATION.md)

+ + [DROP TIMESERIES POLICY](/uqbar-sql-syntax/DROP-TIMESERIES-POLICY.md)

+ + [DROP TIMESERIES TABLE](/uqbar-sql-syntax/DROP-TIMESERIES-TABLE.md)

++ [Third Party Tools Support](/third-party-tools-support/third-party-tools-support.md)

+ + [Kafka](/third-party-tools-support/kafka.md)

+ + [Grafana](/third-party-tools-support/grafana.md)

+ + [Prometheus](./third-party-tools-support/prometheus.md)

++ [Glossary](/glossary.md)

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v1.1/query-data.md b/product/zh/docs-uqbar/v1.1/query-data.md

index 6e09e58df6ac15b9cbfcab6e45c94931cfdc81ee..3776d1aeda9cb439116d7e05e5b7ff2155130043 100644

--- a/product/zh/docs-uqbar/v1.1/query-data.md

+++ b/product/zh/docs-uqbar/v1.1/query-data.md

@@ -28,7 +28,7 @@ Uqbar使用SQL作为查询语言,用户可以通过客户端或者不同的驱

### time_bucket()

-time_bucket时间范围对齐函数,用于将一个时间按照bucket_width对齐到一个时间点,方便后续对时间聚合。

+将时间序列数据按照指定的时间间隔分组,并对这些分组的数据进行聚合操作,如计算平均值、求和等。

#### 语法

@@ -88,15 +88,12 @@ Uqbar=# select time_bucket('2 minute',time) as bucket, sum(value) from t1 group

当前版本的Uqbar支持以下常用选择算子:

-| 函数 | 用途 |

-| ---------- | ------------- |

-| FIRST | 取最早的值 |

-| LAST | 取最晚的值 |

-| MAX | 取最大的值 |

-| MIN | 取最小的值 |

-| PERCENTILE | 计算百分位值 |

-| SAMPLE | 返回N个抽样 |

-| TOP | 取最大的N个值 |

+| 函数 | 用途 |

+| ----- | ---------- |

+| FIRST | 取最早的值 |

+| LAST | 取最晚的值 |

+| MAX | 取最大的值 |

+| MIN | 取最小的值 |

### first() / last()

@@ -167,6 +164,60 @@ shanghai | 29

支持时序表与关系表、时序表与时序表之间join查询。

+```sql

+Uqbar=# CREATE TABLE cpu_info (id int, arch text, cores int, speed float);

+

+Uqbar=# INSERT INTO cpu_info VALUES (1, 'aarch64', 8, 2000);

+Uqbar=# INSERT INTO cpu_info VALUES (2, 'x86_64', 8, 2200);

+Uqbar=# INSERT INTO cpu_info VALUES (3, 'aarch64', 16, 2000);

+Uqbar=# INSERT INTO cpu_info VALUES (4, 'x86_64', 16, 2200);

+

+Uqbar=# DROP TIMESERIES TABLE IF EXISTS cpu;

+Uqbar=# CREATE TIMESERIES TABLE cpu(time timestamp tstime, tags_id int tstag, usage float);

+

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-01 00:00:00', 1, 82);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-01 12:00:00', 1, 83);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-01 23:59:59', 1, 84);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 00:00:00', 1, 92);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 12:00:00', 1, 93);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 23:59:59', 1, 94);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 00:00:00', 2, 84);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 12:00:00', 2, 85);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 23:59:59', 2, 86);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 00:00:00', 3, 93);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 00:00:00', 3, 92);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 00:00:00', 3, 91);

+Uqbar=# INSERT INTO cpu VALUES ('2023-05-02 00:00:00', 5, 91);

+

+Uqbar=# SELECT cpu.time, cpu_info.arch, cpu_info.id, cpu_info.cores, cpu_info.speed FROM cpu LEFT JOIN cpu_info ON cpu.tags_id = cpu_info.id ORDER BY cpu.tags_id,cpu.time ASC;

+ time | arch | id | cores | speed

+---------------------+---------+----+-------+-------

+ 2023-05-01 00:00:00 | aarch64 | 1 | 8 | 2000

+ 2023-05-01 12:00:00 | aarch64 | 1 | 8 | 2000

+ 2023-05-01 23:59:59 | aarch64 | 1 | 8 | 2000

+ 2023-05-02 00:00:00 | aarch64 | 1 | 8 | 2000

+ 2023-05-02 12:00:00 | aarch64 | 1 | 8 | 2000

+ 2023-05-02 23:59:59 | aarch64 | 1 | 8 | 2000

+ 2023-05-02 00:00:00 | x86_64 | 2 | 8 | 2200

+ 2023-05-02 12:00:00 | x86_64 | 2 | 8 | 2200

+ 2023-05-02 23:59:59 | x86_64 | 2 | 8 | 2200

+ 2023-05-02 00:00:00 | aarch64 | 3 | 16 | 2000

+ 2023-05-02 00:00:00 | aarch64 | 3 | 16 | 2000

+ 2023-05-02 00:00:00 | aarch64 | 3 | 16 | 2000

+ 2023-05-02 00:00:00 | | | |

+(13 rows)

+

+Uqbar=# SELECT time_bucket('1 day',time) as bucket, cpu_info.id, avg(usage) FROM cpu LEFT JOIN cpu_info ON cpu.tags_id = cpu_info.id GROUP BY bucket,cpu_info.id ORDER BY cpu_info.id,bucket ASC;

+ bucket | id | avg

+---------------------+----+-----

+ 2023-05-01 00:00:00 | 1 | 83

+ 2023-05-02 00:00:00 | 1 | 93

+ 2023-05-02 00:00:00 | 2 | 85

+ 2023-05-02 00:00:00 | 3 | 92

+ 2023-05-02 00:00:00 | | 91

+(5 rows)

+```

+

## 索引

diff --git a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.bgw_job.md b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.bgw_job.md

index 757c760d2873ecd1ae0f8c59766d5082e3d77e8c..517b3457f7caf4daaef12c9e901500ae793bd2f3 100644

--- a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.bgw_job.md

+++ b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.bgw_job.md

@@ -9,7 +9,7 @@ date: 2022-11-24

Uqbar提供后台任务视图,供用户查看定期删除、压缩等后台任务的运行状况。timeseries_views这个schema下提供了bgw_job视图,供用户查看所有时序表策略。

-**表1** bgw_job视图属性:

+**表1** bgw_job视图属性

| 字段 | 类型 | 描述 |

| :------------ | :-------- | :----------------------------------------------------------- |

diff --git a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_chunkgroup.md b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_chunkgroup.md

index 89fe29aba128b5fe0b4d177713def10a214bfcfd..0078be4ee41ed3612594aea65b4ccb25d8ff3568 100644

--- a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_chunkgroup.md

+++ b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_chunkgroup.md

@@ -9,7 +9,7 @@ date: 2022-11-24

timeseries_views模式下的compression_chunkgroup视图,供用户查看所有时序表分片的压缩率。after_compression_size和compression_ratio仅在chunkgroup被压缩后非空。

-**表1** compression_chunkgroup视图属性:

+**表1** compression_chunkgroup视图属性

| 字段 | 类型 | 描述 |

| :---------------------- | :----- | :--------------------------------- |

diff --git a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_table.md b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_table.md

index ce4662f072cfe52d0d1de7565de068d3cbbc01cc..6473ad3f8c421b212bb2ab52426981ea287a55d7 100644

--- a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_table.md

+++ b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.compression_table.md

@@ -9,7 +9,7 @@ date: 2022-11-24

timeseries_views模式下的compression_table视图,供用户查看所有时序表的压缩率。after_compression_size和compression_ratio仅在时序表存在至少一个被压缩的chunkgroup时非空。当存在至少一个chunkGroup被压缩后,after_compression_size为未压缩的chunkGroup的before_compression_size与被压缩的chunkGroup的after_compression_size之和。

-**表1** compression_table视图属性:

+**表1** compression_table视图属性

| 字段 | 类型 | 描述 |

| :---------------------- | :----- | :----------------------------- |

diff --git a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.policies.md b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.policies.md

index 00a37eccd84860c4a848ee56a0dd3238ee6a895c..8258cca4f571c949a17e80e7178735238d2f7bb3 100644

--- a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.policies.md

+++ b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.policies.md

@@ -9,7 +9,7 @@ date: 2022-11-24

Uqbar支持查看指定数据库下的所有保留策略。timeseries_views这个schema下提供了policies视图,供用户查看所有时序表策略。

-**表1** policies视图属性:

+**表1** policies视图属性

| 字段 | 类型 | 描述 |

| :----------------- | :------- | :--------------------------------------------------------- |

diff --git a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tschunkgroup.md b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tschunkgroup.md

index 536fc8e878ae16bf6376ab9c5a2604bc3f1144a1..97c7111d958642238daacf36807a01908bcc0014 100644

--- a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tschunkgroup.md

+++ b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tschunkgroup.md

@@ -9,7 +9,7 @@ date: 2022-11-24

用户可查看一个时序表的ChunkGroup列表视图。时序表按照时间范围被拆分为多个分片组(ChunkGroup),以分片组为单位进行过期删除,以便于对时序数据进行高效过期删除。

-**表1** tschunkgroup视图属性:

+**表1** tschunkgroup视图属性

| 字段 | 类型 | 描述 |

| :----------------- | :------- | :--------------------------------------- |

diff --git a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tstable.md b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tstable.md

index 50ae8e712e9ec5152f1e4da190b87670f0b53002..c7d5cd6b03545547bbd7870fa6a46a1a0e52cc01 100644

--- a/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tstable.md

+++ b/product/zh/docs-uqbar/v1.1/timeseries-views/timeseries_views.tstable.md

@@ -9,7 +9,7 @@ date: 2022-11-24

用户可查看当前数据库下的所有时序表。

-**表1** tstable视图属性:

+**表1** tstable视图属性

| 字段 | 类型 | 描述 |

| :---------- | :----- | :--------------------- |

diff --git a/product/zh/docs-uqbar/v1.1/toc.md b/product/zh/docs-uqbar/v1.1/toc.md

index 8271e70e7e0d8c5ba18b0d0414948d2129344df1..c4a2e187748368e9d59565b4648a36a709ec32db 100644

--- a/product/zh/docs-uqbar/v1.1/toc.md

+++ b/product/zh/docs-uqbar/v1.1/toc.md

@@ -45,7 +45,7 @@

+ [DROP TIMESERIES TABLE](/uqbar-sql-syntax/DROP-TIMESERIES-TABLE.md)

+ [first()/last()](/uqbar-sql-syntax/first-last.md)

+ [time_bucket](/uqbar-sql-syntax/time_bucket.md)

-+ [三方工具支持](/third-party-tools-support/third-party-tools-support.md)

++ [第三方工具支持](/third-party-tools-support/third-party-tools-support.md)

+ [Kafka](/third-party-tools-support/kafka.md)

+ [Grafana](/third-party-tools-support/grafana.md)

+ [术语](/glossary.md)

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v1.1/uqbar-sql-syntax/CREATE-TIMESERIES-TABLE.md b/product/zh/docs-uqbar/v1.1/uqbar-sql-syntax/CREATE-TIMESERIES-TABLE.md

index 4710d500173c1b30e1f8d69dceb47b1c0f332288..ee960fb666e597b963546324128487d9c3e31804 100644

--- a/product/zh/docs-uqbar/v1.1/uqbar-sql-syntax/CREATE-TIMESERIES-TABLE.md

+++ b/product/zh/docs-uqbar/v1.1/uqbar-sql-syntax/CREATE-TIMESERIES-TABLE.md

@@ -15,7 +15,7 @@ date: 2022-11-22

- 必须要指定 TSTIME 和 TSTAG 列。

-- 只能有一列指定为 TSTIME 列,且数据类型只能为时间类型,包括 timestamp [without time zone]、timestamp with time zone。openGauss中的 date 类型,内部实际类型是 timestamp [without time zone],除了日期外同时也包含时间信息,TSTIME 也可以支持 date 类型。而 “date” 类型只包含日期信息,不包含时间信息,所以不支持。

+- 只能有一列指定为 TSTIME 列,且数据类型只能为时间类型,包括 timestamp [without time zone]、timestamp with time zone。

- 支持数量为 [1, 32] 的列指定为 TSTAG,只允许数据类型为字符串类型 ,包括 “char”、char(n)、character(n)、nchar(n)、bpchar(n)、varchar(n)、character varying(n)、nvarchar(n)、varchar2(n)、nvarchar2(n) 和 text,不支持 clob 和 name。

@@ -27,8 +27,6 @@ date: 2022-11-22

- TSTIME 不支持用户设置 default,系统默认设置 TSTIME 为当前时间。

-- Field 列允许用户设置 NOT NULL。

-

- Field 列不支持自定义的数据类型,由于列存数据类型的限制,支持的数据类型如下( DATE 和 DATEARRAY 中 DATE 类型指的是 “date” 而不是 date) :

BOOL、HLL、BYTEA、CHAR、INT8、INT2、INT4、INT1、NUMERIC、BPCHAR、VARCHAR、NVARCHAR2、SMALLDATETIME、TEXT、OID、FLOAT4、FLOAT8、ABSTIME、RELTIME、TINTERVAL、INET、DATE、TIME、TIMESTAMP、TIMESTAMPTZ、INTERVAL、TIMETZ、MONEY、CIDR、BIT、VARBIT、CLOB、BOOLARRAY、HLL_ARRAY、BYTEARRAY、CHARARRAY、INT8ARRAY、INT2ARRAY、INT4ARRAY、INT1ARRAY、NUMERICARRAY、BPCHARARRAY、VARCHARARRAY、NVARCHAR2ARRAY、SMALLDATETIMEARRAY、TEXTARRAY、FLOAT4ARRAY、FLOAT8ARRAY、ABSTIMEARRAY、RELTIMEARRAY、INTERVALARRAY、INETARRAY、DATEARRAY、TIMEARRAY、TIMESTAMPARRAY、TIMESTAMPTZARRAY、ARRAYINTERVAL、TIMETZARRAY、MONEYARRAY、CIDRARRAY、BITARRAY、VARBITARRAY

diff --git a/product/zh/docs-uqbar/v2.0/backup-restore.md b/product/zh/docs-uqbar/v2.0/backup-restore.md

new file mode 100644

index 0000000000000000000000000000000000000000..9cd9a22f9a218964f53841545423771974d0efde

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/backup-restore.md

@@ -0,0 +1,986 @@

+---

+title: 备份恢复

+summary: 备份恢复

+author: Guo Huan

+date: 2022-11-24

+---

+

+# 备份恢复

+

+时序数据库提供数据备份恢复的工具,通过数据备份达到容灾的目的。

+

+Uqbar支持物理备份及恢复;物理备份支持全量备份和增量备份两种模式。时序表支持物理备份。

+

+## gs_basebackup

+

+### 背景信息

+

+Uqbar部署成功后,在数据库运行的过程中,会遇到各种问题及异常状态。Uqbar提供了gs_basebackup工具做基础的物理备份。gs_basebackup的实现目标是对服务器数据库文件的二进制进行拷贝,其实现原理使用了复制协议。远程执行gs_basebackup时,需要使用系统管理员账户。gs_basebackup当前支持热备份模式和压缩格式备份模式。

+

+>  **说明**:

+>

+> - gs_basebackup仅支持主机和备机的全量备份,不支持增量。

+> - gs_basebackup当前支持热备份模式和压缩格式备份模式。

+> - 若打开增量检测点功能且打开双写,gs_basebackup也会备份双写文件。

+> - gs_basebackup在备份包含绝对路径的表空间时,如果在同一台机器上进行备份,可以通过tablespace-mapping重定向表空间路径,或使用归档模式进行备份。

+> - 若pg_xlog目录为软链接,备份时将不会建立软链接,会直接将数据备份到目的路径的pg_xlog目录下。

+> - 备份过程中收回用户备份权限,可能导致备份失败,或者备份数据不可用。

+> - 如果因为网络临时故障等原因导致Server端无法应答,gs_basebackup将在最长等待120秒后退出。

+

+### 前提条件

+

+- 可以正常连接Uqbar数据库。

+- 备份过程中用户权限没有被回收。

+- pg_hba.conf中需要配置允许复制链接,且该连接必须由一个系统管理员建立。

+- 如果xlog传输模式为stream模式,需要配置max_wal_senders的数量,至少有一个可用。

+- 如果xlog传输模式为fetch模式,有必要把wal_keep_segments参数设置得足够高,这样在备份末尾之前日志不会被移除。

+- 在进行还原时,需要保证各节点备份目录中存在备份文件,若备份文件丢失,则需要从其他节点进行拷贝。

+

+### 语法

+

+- 显示帮助信息

+

+ ```bash

+ gs_basebackup -? | --help

+ ```

+

+- 显示版本号信息

+

+ ```bash

+ gs_basebackup -V | --version

+ ```

+

+### 参数说明

+

+gs_basebackup参数可以分为如下几类:

+

+- -D directory

+

+ 备份文件输出的目录,必选项。

+

+- 常用参数:

+

+ - -c,--checkpoint=fast|spread

+

+ 设置检查点模式为fast或者spread(默认)。

+

+ - -l,--label=LABEL

+

+ 为备份设置标签。

+

+ - -P,--progress

+

+ 启用进展报告。

+

+ - -v, --verbose

+

+ 启用冗长模式。

+

+ - -V, --version

+

+ 打印版本后退出。

+

+ - -?,--help

+

+ 显示gs_basebackup命令行参数。

+

+ - -T,--tablespace-mapping=olddir=newdir

+

+ 在备份期间将目录olddir中的表空间重定位到newdir中。为使之有效,olddir必须正好匹配表空间所在的路径(但如果备份中没有包含olddir中的表空间也不是错误)。olddir和newdir必须是绝对路径。如果一个路径凑巧包含了一个=符号,可用反斜线对它转义。对于多个表空间可以多次使用这个选项。

+

+ - -F,--format=plain|tar

+

+ 设置输出格式为plain(默认)或者tar。没有设置该参数的情况下,默认--format=plain。plain格式把输出写成平面文件,使用和当前数据目录和表空间相同的布局。当集簇没有额外表空间时,整个数据库将被放在目标目录中。如果集簇包含额外的表空间,主数据目录将被放置在目标目录中,但是所有其他表空间将被放在它们位于服务器上的相同的绝对路径中。tar模式将输出写成目标目录中的 tar 文件。主数据目录将被写入到一个名为base.tar的文件中,并且其他表空间将被以其 OID 命名。生成的tar包,需要用gs_tar命令解压。

+

+ - -X, --xlog-method=fetch|stream

+

+ 设置xlog传输方式。没有设置该参数的情况下,默认--xlog-method=stream。在备份中包括所需的预写式日志文件(WAL文件)。这包括所有在备份期间产生的预写式日志。fetch方式在备份末尾收集预写式日志文件。因此,有必要把wal_keep_segments参数设置得足够高,这样在备份末尾之前日志不会被移除。如果在要传输日志时它已经被轮转,备份将失败并且是不可用的。stream方式在备份被创建时流传送预写式日志。这将开启一个到服务器的第二连接并且在运行备份时并行开始流传输预写式日志。因此,它将使用最多两个由max_wal_senders参数配置的连接。只要客户端能保持接收预写式日志,使用这种模式不需要在主控机上保存额外的预写式日志。

+

+ - -x,--xlog 使用这个选项等效于和方法fetch一起使用-X。

+

+ - -Z --compress=level

+

+ 启用对 tar 文件输出的 gzip 压缩,并且制定压缩级别(0 到 9,0 是不压缩,9 是最佳压缩)。只有使用 tar 格式时压缩才可用,并且会在所有tar文件名后面自动加上后缀.gz。

+

+ - -z

+

+ 启用对 tar 文件输出的 gzip 压缩,使用默认的压缩级别。只有使用 tar 格式时压缩才可用,并且会在所有tar文件名后面自动加上后缀.gz。

+

+ - -t,--rw-timeout

+

+ 设置备份期间checkpoint的时间限制,默认限制时间为120s。当数据库全量checkpoint耗时较长时,可以适当增大rw-timeout限制时间。

+

+- 连接参数

+

+ - -h, --host=HOSTNAME

+

+ 指定正在运行服务器的主机名或者Unix域套接字的路径。

+

+ - -p,--port=PORT

+

+ 指定数据库服务器的端口号。

+

+ 可以通过port参数修改默认端口号。

+

+ - -U,--username=USERNAME

+

+ 指定连接数据库的用户。

+

+ - -s, --status-interval=INTERVAL

+

+ 发送到服务器的状态包的时间(以秒为单位)。

+

+ - -w,--no-password

+

+ 不出现输入密码提示。

+

+ - -W, --password

+

+ 当使用-U参数连接本地数据库或者连接远端数据库时,可通过指定该选项出现输入密码提示。

+

+### 示例

+

+```bash

+gs_basebackup -D /home/test/trunk/install/data/backup -h 127.0.0.1 -p 21233

+INFO: The starting position of the xlog copy of the full build is: 0/1B800000. The slot minimum LSN is: 0/1B800000.

+```

+

+### 从备份文件恢复数据

+

+当数据库发生故障时需要从备份文件进行恢复。因为gs_basebackup是对数据库按二进制进行备份,因此恢复时可以直接拷贝替换原有的文件,或者直接在备份的库上启动数据库。

+

+>  **说明**:

+>

+> - 若当前数据库实例正在运行,直接从备份文件启动数据库可能会存在端口冲突,这时需要修改配置文件的port参数,或者在启动数据库时指定一下端口。

+> - 若当前备份文件为主备数据库,可能需要修改一下主备之间的复制连接。即配置文件postgresql.conf中的replconninfo1,replconninfo2等。

+> - 若配置文件postgresql.conf的参数data_directory打开且有配置,当使用备份目录启动数据库时候,data_directory和备份目录不同会导致启动失败。可以修改data_directory的值为新的数据目录,或者注释掉该参数。

+

+若要在原库的地方恢复数据库,参考步骤如下:

+

+1. 停止数据库服务器,具体操作请参见《管理指南》。

+2. 将原数据库和所有表空间复制到另外一个位置, 以备后面需要。

+3. 清理原库中的所有或部分文件。

+4. 使用数据库系统用户权限从备份中还原需要的数据库文件。

+5. 若数据库中存在链接文件,需要修改使其链接到正确的文件。

+6. 重启数据库服务器,并检查数据库内容,确保数据库已经恢复到所需的状态。

+

+>  **说明**:

+>

+> - 暂不支持备份文件增量恢复。

+> - 恢复后需要检查数据库中的链接文件是否链接到正确的文件。

+

+

+

+## gs_probackup

+

+### 背景信息

+

+gs_probackup是一个用于管理Uqbar数据库备份和恢复的工具。它对Uqbar实例进行定期备份,以便在数据库出现故障时能够恢复服务器。

+

+- 可用于备份单机数据库,也可对主机或者主节点数据库备机进行备份,为物理备份。

+- 可备份外部目录的内容,如脚本文件、配置文件、日志文件、dump文件等。

+- 支持增量备份、定期备份和远程备份。

+- 可设置备份的留存策略。

+

+### 前提条件

+

+- 可以正常连接Uqbar数据库。

+- 若要使用PTRACK增量备份,需在postgresql.conf中手动添加参数“enable_cbm_tracking = on”。

+- 为了防止xlog在传输结束前被清理,请适当调高postgresql.conf文件中wal_keep_segments的值。

+

+### 限制说明

+

+- 备份必须由运行数据库服务器的用户执行。

+- 备份和恢复的数据库服务器的主版本号必须相同。

+- 如果要通过ssh在远程模式下备份数据库,需要在本地和远程主机安装相同主版本的数据库,并通过ssh-copy-id remote_user@remote_host命令设置本地主机备份用户和远程主机数据库用户的无密码ssh连接。

+- 远程模式下只能执行add-instance、backup、restore子命令。

+- 使用restore子命令前,应先停止uqbar进程。

+- 当存在用户自定义表空间时,备份的时候要加上--external-dirs 参数,否则,该表空间不会被备份。

+- 当备份的规模比较大时,为了防止备份过程中timeout发生,请适当调整postgresql.conf文件的参数 session_timeout、wal_sender_timeout。并且在备份的命令行参数中适当调整参数--rw-timeout的值。

+- 恢复时,使用-T选项把备份中的外部目录重定向到新目录时,请同时指定参数--external-mapping。

+- 当使用远程备份时,请确保远程机器和备份机器的时钟同步,以防止使用--recovery-target-time恢复的场合,启动uqbar时有可能会失败。

+- 当远程备份有效时\(remote-proto=ssh\),请确保-h和--remote-host指定的是同一台机器。当远程备份无效时,如果指定了-h选项,请确保-h指定的是本机地址或本机主机名。

+- 当前暂不支持备份逻辑复制槽。

+

+### 命令说明

+

+- 打印gs_probackup版本。

+

+ ```bash

+ gs_probackup -V|--version

+ gs_probackup version

+ ```

+

+- 显示gs_probackup命令的摘要信息。如果指定了gs_probackup的子命令,则显示可用于此子命令的参数的详细信息。

+

+ ```bash

+ gs_probackup -?|--help

+ gs_probackup help [command]

+ ```

+

+- 初始化备份路径_backup-path_中的备份目录,该目录将存储已备份的内容。如果备份路径_backup-path_已存在,则_backup-path_必须为空目录。

+

+ ```bash

+ gs_probackup init -B backup-path [--help]

+ ```

+

+- 在备份路径_backup-path_内初始化一个新的备份实例,并生成pg_probackup.conf配置文件,该文件保存了指定数据目录_pgdata-path_的gs_probackup设置。

+

+ ```bash

+ gs_probackup add-instance -B backup-path -D pgdata-path --instance=instance_name

+ [-E external-directories-paths]

+ [remote_options]

+ [--help]

+ ```

+

+- 在备份路径_backup-path_内删除指定实例相关的备份内容。

+

+ ```bash

+ gs_probackup del-instance -B backup-path --instance=instance_name

+ [--help]

+ ```

+

+- 将指定的连接、压缩、日志等相关设置添加到pg_probackup.conf配置文件中,或修改已设置的值。不推荐手动编辑pg_probackup.conf配置文件。

+

+ ```bash

+ gs_probackup set-config -B backup-path --instance=instance_name

+ [-D pgdata-path] [-E external-directories-paths] [--archive-timeout=timeout]

+ [--retention-redundancy=retention-redundancy] [--retention-window=retention-window] [--wal-depth=wal-depth]

+ [--compress-algorithm=compress-algorithm] [--compress-level=compress-level]

+ [-d dbname] [-h hostname] [-p port] [-U username]

+ [logging_options] [remote_options]

+ [--help]

+ ```

+

+- 将备份相关设置添加到backup.control配置文件中,或修改已设置的值。

+

+ ```bash

+ gs_probackup set-backup -B backup-path --instance=instance_name -i backup-id

+ [--note=text] [pinning_options]

+ [--help]

+ ```

+

+- 显示位于备份目录中的pg_probackup.conf配置文件的内容。可以通过指定--format=json选项,以json格式显示。默认情况下,显示为纯文本格式。

+

+ ```bash

+ gs_probackup show-config -B backup-path --instance=instance_name

+ [--format=plain|json]

+ [--help]

+ ```

+

+- 显示备份目录的内容。如果指定了instance_name和backup_id,则显示该备份的详细信息。可以通过指定--format=json选项,以json格式显示。默认情况下,备份目录的内容显示为纯文本格式。

+

+ ```bash

+ gs_probackup show -B backup-path

+ [--instance=instance_name [-i backup-id]] [--archive] [--format=plain|json]

+ [--help]

+ ```

+

+- 创建指定实例的备份。

+

+ ```bash

+ gs_probackup backup -B backup-path --instance=instance_name -b backup-mode

+ [-D pgdata-path] [-C] [-S slot-name] [--temp-slot] [--backup-pg-log] [-j threads_num] [--progress]

+ [--no-validate] [--skip-block-validation] [-E external-directories-paths] [--no-sync] [--note=text]

+ [--archive-timeout=timeout] [-t rwtimeout]

+ [logging_options] [retention_options] [compression_options]

+ [connection_options] [remote_options] [pinning_options]

+ [--help]

+ ```

+

+- 从备份目录_backup-path_中的备份副本恢复指定实例。如果指定了恢复目标选项,gs_probackup将查找最近的备份并将其还原到指定的恢复目标。否则,使用最近一次备份。

+

+ ```bash

+ gs_probackup restore -B backup-path --instance=instance_name

+ [-D pgdata-path] [-i backup_id] [-j threads_num] [--progress] [--force] [--no-sync] [--no-validate] [--skip-block-validation]

+ [--external-mapping=OLDDIR=NEWDIR] [-T OLDDIR=NEWDIR] [--skip-external-dirs] [-I incremental_mode]

+ [recovery_options] [remote_options] [logging_options]

+ [--help]

+ ```

+

+- 将指定的增量备份与其父完全备份之间的所有增量备份合并到父完全备份。父完全备份将接收所有合并的数据,而已合并的增量备份将作为冗余被删除。

+

+ ```bash

+ gs_probackup merge -B backup-path --instance=instance_name -i backup_id

+ [-j threads_num] [--progress] [logging_options]

+ [--help]

+ ```

+

+- 删除指定备份,或删除不满足当前保留策略的备份。

+

+ ```bash

+ gs_probackup delete -B backup-path --instance=instance_name

+ [-i backup-id | --delete-expired | --merge-expired | --status=backup_status]

+ [--delete-wal] [-j threads_num] [--progress]

+ [--retention-redundancy=retention-redundancy] [--retention-window=retention-window]

+ [--wal-depth=wal-depth] [--dry-run]

+ [logging_options]

+ [--help]

+ ```

+

+- 验证恢复数据库所需的所有文件是否存在且未损坏。如果未指定_instance_name_,gs_probackup将验证备份目录中的所有可用备份。如果指定_instance_name_而不指定任何附加选项,gs_probackup将验证此备份实例的所有可用备份。如果指定了_instance_name_并且指定_backup-id_或恢复目标相关选项,gs_probackup将检查是否可以使用这些选项恢复数据库。

+

+ ```bash

+ gs_probackup validate -B backup-path

+ [--instance=instance_name] [-i backup-id]

+ [-j threads_num] [--progress] [--skip-block-validation]

+ [--recovery-target-time=time | --recovery-target-xid=xid | --recovery-target-lsn=lsn | --recovery-target-name=target-name]

+ [--recovery-target-inclusive=boolean]

+ [logging_options]

+ [--help]

+ ```

+

+### 参数说明

+

+#### 通用参数

+

+- command

+

+ gs_probackup除version和help以外的子命令:init、add-instance、del-instance、set-config、set-backup、show-config、show、backup、restore、merge、delete、validate。

+

+- -?, --help

+

+ 显示gs_probackup命令行参数的帮助信息,然后退出。

+

+ 子命令中只能使用-help,不能使用-?。

+

+- -V, --version

+

+ 打印gs_probackup版本,然后退出。

+

+- -B *backup-path*, --backup-path=*backup-path*

+

+ 备份的路径。

+

+ 系统环境变量:$BACKUP_PATH

+

+- -D *pgdata-path*, --pgdata=*pgdata-path*

+

+ 数据目录的路径。

+

+ 系统环境变量:$PGDATA

+

+- --instance=*instance_name*

+

+ 实例名。

+

+- -i *backup-id*, --backup-id=*backup-id*

+

+ 备份的唯一标识。

+

+- --format=*format*

+

+ 指定显示备份信息的格式,支持plain和json格式。

+

+ 默认值:plain

+

+- --status=*backup_status*

+

+ 删除指定状态的所有备份,包含以下状态:

+

+ - OK:备份已完成且有效。

+ - DONE:备份已完成但未经过验证。

+ - RUNNING:备份正在进行中。

+ - MERGING:备份正在合并中。

+ - DELETING:备份正在删除中。

+ - CORRUPT:部分备份文件已损坏。

+ - ERROR:由于意外错误,备份失败。

+ - ORPHAN:由于其父备份之一已损坏或丢失,备份无效。

+

+- -j *threads_num*, --threads=*threads_num*

+

+ 设置备份、还原、合并进程的并行线程数。

+

+- --archive

+

+ 显示WAL归档信息。

+

+- --progress

+

+ 显示进度。

+

+- --note=*text*

+

+ 给备份添加note。

+

+#### 备份相关参数

+

+- -b *backup-mode*, --backup-mode=*backup-mode*

+

+ 指定备份模式,支持FULL和PTRACK。

+

+ FULL:创建全量备份,全量备份包含所有数据文件。

+

+ PTRACK:创建PTRACK增量备份。

+

+- -C, --smooth-checkpoint

+

+ 将检查点在一段时间内展开。默认情况下,gs_probackup会尝试尽快完成检查点。

+

+- -S *slot-name*, --slot=*slot-name*

+

+ 指定WAL流处理的复制slot。

+

+- --temp-slot

+

+ 在备份的实例中为WAL流处理创建一个临时物理复制slot,它确保在备份过程中,所有所需的WAL段仍然是可用的。

+

+ 默认的slot名为pg_probackup_slot,可通过选项--slot/-S更改。

+

+- --backup-pg-log

+

+ 将日志目录包含到备份中。此目录通常包含日志消息。默认情况下包含日志目录,但不包含日志文件。如果修改了默认的日志路径,需要备份日志文件时可使用-E参数进行备份,使用方法见下文。

+

+- -E *external-directories-paths*, --external-dirs=*external-directories-paths*

+

+ 将指定的目录包含到备份中。此选项对于备份位于数据目录外部的脚本、sql转储和配置文件很有用。如果要备份多个外部目录,请在Unix上用冒号分隔它们的路径。

+

+ 例如:-E /tmp/dir1:/tmp/dir2

+

+- --skip-block-validation

+

+ 关闭块级校验,加快备份速度。

+

+- --no-validate

+

+ 在完成备份后跳过自动验证。

+

+- --no-sync

+

+ 不将备份文件同步到磁盘。

+

+- --archive-timeout=*timeout*

+

+ 以秒为单位设置流式处理的超时时间。

+

+ 默认值:300

+

+- -t rwtimeout

+

+ 以秒为单位的连接的超时时间。

+

+ 默认值: 120

+

+#### 恢复相关参数

+

+- -I, --incremental-mode=none|checksum|lsn

+

+ 若PGDATA中可用的有效页没有修改,则重新使用它们。

+

+ 默认值:none

+

+- --external-mapping=*OLDDIR=NEWDIR*

+

+ 在恢复时,将包含在备份中的外部目录从_OLDDIR_重新定位到_NEWDIR_目录。_OLDDIR_和_NEWDIR_都必须是绝对路径。如果路径中包含“=”,则使用反斜杠转义。此选项可为多个目录多次指定。

+

+- -T *OLDDIR=NEWDIR*, --tablespace-mapping=*OLDDIR=NEWDIR*

+

+ 在恢复时,将表空间从_OLDDIR_重新定位到_NEWDIR_目录。_OLDDIR_和_NEWDIR_必须都是绝对路径。如果路径中包含“=”,则使用反斜杠转义。多个表空间可以多次指定此选项。此选项必须和--external-mapping一起使用。

+

+- --skip-external-dirs

+

+ 跳过备份中包含的使用-external-dirs选项指定的外部目录。这些目录的内容将不会被恢复。

+

+- --skip-block-validation

+

+ 跳过块级校验,以加快验证速度。在恢复之前的自动验证期间,将仅做文件级别的校验。

+

+- --no-validate

+

+ 跳过备份验证。

+

+- --force

+

+ 允许忽略备份的无效状态。如果出于某种原因需要从损坏的或无效的备份中恢复数据,可以使用此标志。请谨慎使用。

+

+#### 恢复目标相关参数(recovery_options)

+

+>  **说明**: 当前不支持配置连续的WAL归档的PITR,因而使用这些参数会有一定限制,具体如下描述。 如果需要使用持续归档的WAL日志进行PITR恢复,请按照下面描述的步骤:

+>

+> 1. 将物理备份的文件替换目标数据库目录。

+> 2. 删除数据库目录下pg_xlog/中的所有文件。

+> 3. 将归档的WAL日志文件复制到pg_xlog文件中(此步骤可以省略,通过配置recovery.conf恢复命令文件中的restore_command项替代)。

+> 4. 在数据库目录下创建恢复命令文件recovery.conf,指定数据库恢复的程度。

+> 5. 启动数据库。

+> 6. 连接数据库,查看是否恢复到希望预期的状态。若已经恢复到预期状态,通过pg_xlog_replay_resume()指令使主节点对外提供服务。

+

+- --recovery-target-lsn=*lsn*

+

+ 指定要恢复到的lsn,当前只能指定备份的stop lsn。

+

+- --recovery-target-name=*target-name*

+

+ 指定要将数据恢复到的已命名的保存点,保存点可以通过查看备份中recovery-name字段得到。

+

+- --recovery-target-time=*time*

+

+ 指定要恢复到的时间,当前只能指定备份中的recovery-time。

+

+- --recovery-target-xid=*xid*

+

+ 指定要恢复到的事务ID,当前只能指定备份中的recovery-xid。

+

+- --recovery-target-inclusive=*boolean*

+

+ 当该参数指定为true时,恢复目标将包括指定的内容。

+

+ 当该参数指定为false时,恢复目标将不包括指定的内容。

+

+ 该参数必须和--recovery-target-name、--recovery-target-time、--recovery-target-lsn或--recovery-target-xid一起使用。

+

+#### 留存相关参数(retention_options)

+

+>  **说明**: 可以和backup和delete命令一起使用这些参数。

+

+- --retention-redundancy=*retention-redundancy*

+

+ 指定在数据目录中留存的完整备份数。必须为正整数。0表示禁用此设置。

+

+ 默认值:0

+

+- --retention-window=*retention-window*

+

+ 指定留存的天数。必须为正整数。0表示禁用此设置。

+

+ 默认值:0

+

+- --wal-depth=*wal-depth*

+

+ 每个时间轴上必须留存的执行PITR能力的最新有效备份数。必须为正整数。0表示禁用此设置。

+

+ 默认值:0

+

+- --delete-wal

+

+ 从任何现有的备份中删除不需要的WAL文件。

+

+- --delete-expired

+

+ 删除不符合pg_probackup.conf配置文件中定义的留存策略的备份。

+

+- --merge-expired

+

+ 将满足留存策略要求的最旧的增量备份与其已过期的父备份合并。

+

+- --dry-run

+

+ 显示所有可用备份的当前状态,不删除或合并过期备份。

+

+#### 固定备份相关参数(pinning_options)

+

+>  **说明**: 如果要将某些备份从已建立的留存策略中排除,可以和backup和set-backup命令一起使用这些参数。

+

+- --ttl=*interval*

+

+ 指定从恢复时间开始计算,备份要固定的时间量。必须为正整数。0表示取消备份固定。

+

+ 支持的单位:ms、 s、 min、 h、 d(默认为s)。

+

+ 例如:-ttl=30d。

+

+- --expire-time=*time*

+

+ 指定备份固定失效的时间戳。必须是ISO-8601标准的时间戳。

+

+ 例如:--expire-time='2020-01-01 00:00:00+03'

+

+#### 日志相关参数(logging_options)

+

+日志级别:verbose、log、info、warning、error和off。

+

+- --log-level-console=*log-level-console*

+

+ 设置要发送到控制台的日志级别。每个级别都包含其后的所有级别。级别越高,发送的消息越少。指定off级别表示禁用控制台日志记录。

+

+ 默认值:info

+

+- --log-level-file=*log-level-file*

+

+ 设置要发送到日志文件的日志级别。每个级别都包含其后的所有级别。级别越高,发送的消息越少。指定off级别表示禁用日志文件记录。

+

+ 默认值:off

+

+- --log-filename=*log-filename*

+

+ 指定要创建的日志文件的文件名。文件名可以使用strftime模式,因此可以使用%-escapes指定随时间变化的文件名。

+

+ 例如,如果指定了“pg_probackup-%u.log”模式,则pg_probackup为每周的每一天生成单独的日志文件,其中%u替换为相应的十进制数字,即pg_probackup-1.log表示星期一;pg_probackup-2.log表示星期二,以此类推。

+

+ 如果指定了--log-level-file参数启用日志文件记录,则该参数有效。

+

+ 默认值:“pg_probackup.log”

+

+- --error-log-filename=*error-log-filename*

+

+ 指定仅用于error日志的日志文件名。指定方式与--log-filename参数相同。

+

+ 此参数用于故障排除和监视。

+

+- --log-directory=*log-directory*

+

+ 指定创建日志文件的目录。必须是绝对路径。此目录会在写入第一条日志时创建。

+

+ 默认值:$BACKUP_PATH/log

+

+- --log-rotation-size=*log-rotation-size*

+

+ 指定单个日志文件的最大大小。如果达到此值,则启动gs_probackup命令后,日志文件将循环,但help和version命令除外。0表示禁用基于文件大小的循环。

+

+ 支持的单位:KB、MB、GB、TB(默认为KB)。

+

+ 默认值:0

+

+- --log-rotation-age=*log-rotation-age*

+

+ 单个日志文件的最大生命周期。如果达到此值,则启动gs_probackup命令后,日志文件将循环,但help和version命令除外。$BACKUP_PATH/log/log_rotation目录下保存最后一次创建日志文件的时间。0表示禁用基于时间的循环。

+

+ 支持的单位:ms、 s、 min、 h、 d(默认为min)。

+

+ 默认值:0

+

+#### 连接相关参数(connection_options)

+

+>  **说明**: 可以和backup命令一起使用这些参数。

+

+- -d *dbname*, --pgdatabase=*dbname*

+

+ 指定要连接的数据库名称。该连接仅用于管理备份进程,因此您可以连接到任何现有的数据库。如果命令行、PGDATABASE环境变量或pg_probackup.conf配置文件中没有指定此参数,则gs_probackup会尝试从PGUSER环境变量中获取该值。如果未设置PGUSER变量,则从当前用户名获取。

+

+ 系统环境变量:$PGDATABASE

+

+- -h *hostname*, --pghost=*hostname*

+

+ 指定运行服务器的系统的主机名。如果该值以斜杠开头,则被用作到Unix域套接字的路径。

+

+ 系统环境变量:$PGHOST

+

+ 默认值:local socket

+

+- -p *port*, --pgport=_p_*ort*

+

+ 指定服务器正在侦听连接的TCP端口或本地Unix域套接字文件扩展名。

+

+ 系统环境变量:$PGPORT

+

+ 默认值:5432

+

+- -U *username*, --pguser=*username*

+

+ 指定所连接主机的用户名。

+

+ 系统环境变量:$PGUSER

+

+- -w, --no-password

+

+ 不出现输入密码提示。如果主机要求密码认证并且密码没有通过其它形式给出,则连接尝试将会失败。 该选项在批量工作和不存在用户输入密码的脚本中很有帮助。

+

+- -W *password*, --password=*password*

+

+ 指定用户连接的密码。如果主机的认证策略是trust,则不会对系统管理员进行密码验证,即无需输入-W选项;如果没有-W选项,并且不是系统管理员,则会提示用户输入密码。

+

+#### 压缩相关参数(compression_options)

+

+>  **说明**: 可以和backup命令一起使用这些参数。

+

+- --compress-algorithm=*compress-algorithm*

+

+ 指定用于压缩数据文件的算法。

+

+ 取值包括zlib、pglz和none。如果设置为zlib或pglz,此选项将启用压缩。默认情况下,压缩功能处于关闭状态。

+

+ 默认值:none

+

+- --compress-level=*compress-level*

+

+ 指定压缩级别。取值范围: 0~9

+

+ - 0表示无压缩。

+ - 1表示压缩比最小,处理速度最快。

+ - 9表示压缩比最大,处理速度最慢。

+ - 可与--compress-algorithm选项一起使用。

+

+ 默认值:1

+

+- --compress

+

+ 以--compress-algorithm=zlib和--compress-level=1进行压缩。

+

+#### 远程模式相关参数(remote_options)

+

+>  **说明**: 通过SSH远程运行gs_probackup操作的相关参数。可以和add-instance、set-config、backup、restore命令一起使用这些参数。

+

+- --remote-proto=*protocol*

+

+ 指定用于远程操作的协议。目前只支持SSH协议。取值包括:

+

+ ssh:通过SSH启用远程备份模式。这是默认值。

+

+ none:显式禁用远程模式。

+

+ 如果指定了-remote-host参数,可以省略此参数。

+

+- --remote-host=*destination*

+

+ 指定要连接的远程主机的IP地址或主机名。

+

+- --remote-port=*port*

+

+ 指定要连接的远程主机的端口号。

+

+ 默认值:22

+

+- --remote-user=*username*

+

+ 指定SSH连接的远程主机用户。如果省略此参数,则使用当前发起SSH连接的用户。

+

+ 默认值:当前用户

+

+- --remote-path=*path*

+

+ 指定gs_probackup在远程系统的安装目录。

+

+ 默认值:当前路径

+

+- --remote-libpath=*libpath*

+

+ 指定gs_probackup在远程系统安装的lib库目录。

+

+- --ssh-options=*ssh_options*

+

+ 指定SSH命令行参数的字符串。

+

+ 例如:--ssh-options='-c cipher_spec -F configfile'

+

+ >  **说明**:

+ >

+ > - 如果因为网络临时故障等原因导致server端无应答,gs_probackup将在等待archive-timeout(默认300秒)后退出。

+ >

+ > - 如果备机lsn与主机有差别时,数据库会不停地刷以下log信息,此时应重新build备机。

+ >

+ > ```bash

+ > LOG: walsender thread shut down

+ > LOG: walsender thread started

+ > LOG: received wal replication command: IDENTIFY_VERSION

+ > LOG: received wal replication command: IDENTIFY_MODE

+ > LOG: received wal replication command: IDENTIFY_SYSTEM

+ > LOG: received wal replication command: IDENTIFY_CONSISTENCE 0/D0002D8

+ > LOG: remote request lsn/crc: [xxxxx] local max lsn/crc: [xxxxx]

+ > ```

+

+### 备份流程

+

+1. 初始化备份目录。在指定的目录下创建backups/和wal/子目录,分别用于存放备份文件和WAL文件。

+

+ ```bash

+ gs_probackup init -B backup_dir

+ ```

+

+2. 添加一个新的备份实例。gs_probackup可以在同一个备份目录下存放多个数据库实例的备份。

+

+ ```bash

+ gs_probackup add-instance -B backup_dir -D data_dir --instance instance_name

+ ```

+

+3. 创建指定实例的备份。在进行增量备份之前,必须至少创建一次全量备份。

+

+ ```bash

+ gs_probackup backup -B backup_dir --instance instance_name -b backup_mode

+ ```

+

+4. 从指定实例的备份中恢复数据。

+

+ ```bash

+ gs_probackup restore -B backup_dir --instance instance_name -D pgdata-path -i backup_id

+ ```

+

+### 故障处理

+

+| 问题描述 | 原因和解决方案 |

+| :----------------------------------------------------------- | :----------------------------------------------------------- |

+| ERROR: query failed: ERROR: canceling statement due to conflict with recovery(错误:查询失败:由于与恢复操作冲突,正在取消语句命令) | 原因:在备机上执行的操作正在访问存储行,主机上更改或者删除了对应的行,并将xlog在备机上重放,迫使备机上操作取消。

解决方案:

1. 适当增加如下配置参数的值

max_standby_archive_delay

max_standby_streaming_delay

2. 增加如下配置

hot_standby_feedback = on |

+

+### 示例

+

+以下为全量备份和增量备份示例,备份目录为/opt/uqbar/backup_dir。

+

+1. 初始化备份目录。在指定的备份目录/opt/uqbar/backup_dir下创建backups/和wal/子目录,分别用于存放备份文件和WAL文件。

+

+ ```bash

+ [ommdoc@hostname]$ gs_probackup init -B /opt/uqbar/backup_dir

+ INFO: Backup catalog '/opt/uqbar/backup_dir' successfully inited

+ ```

+

+2. 添加一个新的备份实例instance1(用户需自定义实例名称)。gs_probackup可以在同一个备份目录下存放多个数据库实例的备份。

+

+ ```bash

+ [ommdoc@hostname]$ gs_probackup add-instance -B /opt/uqbar/backup_dir -D /opt/uqbar/data --instance instance1

+ INFO: Instance 'instance1' successfully inited

+ ```

+

+3. 创建指定实例的全量备份。

+

+ **注意**:如果提示数据库无法连接,请执行如下命令建立数据库连接后再执行全量备份。例如执行如下命令连接到postgres数据库,且端口号为28000。

+

+ ```bash

+ [ommdoc@hostname]$ gs_probackup set-config --instance=instance1 -B /opt/uqbar/backup_dir -d postgres -p 28000

+ ```

+

+ ```bash

+ [ommdoc@hostname]$ gs_probackup backup -B /opt/uqbar/backup_dir --instance instance1 -b FULL

+ INFO: Backup start, gs_probackup version: 2.4.2, instance: instance1, backup ID: RGOZF6, backup mode: FULL, wal mode: STREAM, remote: false, compress-algorithm: none, compress-level: 1

+ LOG: Backup destination is initialized

+ LOG: This openGauss instance was initialized with data block checksums. Data block corruption will be detected

+ LOG: Database backup start

+ LOG: started streaming WAL at 0/CA000000 (timeline 1)

+ INFO: Cannot parse path "base"

+ [2022-08-16 13:04:18]: check identify system success

+ [2022-08-16 13:04:18]: send START_REPLICATION 0/CA000000 success

+ [2022-08-16 13:04:18]: keepalive message is received

+ [2022-08-16 13:04:18]: keepalive message is received

+ INFO: PGDATA size: 1320MB

+ INFO: Start transferring data files

+ LOG: Creating page header map "/opt/uqbar/backup_dir/backups/instance1/RGOZF6/page_header_map"

+ INFO: Data files are transferred, time elapsed: 2s

+ INFO: wait for pg_stop_backup()

+ INFO: pg_stop backup() successfully executed

+ LOG: stop_lsn: 0/CA0001E8

+ LOG: Looking for LSN 0/CA0001E8 in segment: 0000000100000000000000CA

+ LOG: Found WAL segment: /opt/uqbar/backup_dir/backups/instance1/RGOZF6/database/pg_xlog/0000000100000000000000CA

+ LOG: Thread [0]: Opening WAL segment "/opt/uqbar/backup_dir/backups/instance1/RGOZF6/database/pg_xlog/0000000100000000000000CA"

+ LOG: Found LSN: 0/CA0001E8

+ LOG: finished streaming WAL at 0/CB000000 (timeline 1)

+ LOG: Getting the Recovery Time from WAL

+ LOG: Thread [0]: Opening WAL segment "/opt/uqbar/backup_dir/backups/instance1/RGOZF6/database/pg_xlog/0000000100000000000000CA"

+ INFO: Syncing backup files to disk

+ INFO: Backup files are synced, time elapsed: 1s

+ INFO: Validating backup RGOZF6

+ INFO: Backup RGOZF6 data files are valid

+ INFO: Backup RGOZF6 resident size: 1337MB

+ INFO: Backup RGOZF6 completed

+ ```

+

+4. 登录数据库,创建表warehouse_t1。

+

+ ```sql

+ [ommdoc@hostname]$ gsql -d postgres -p 28000

+ gsql ((Uqbar 1.1.0 build 62408a0f) compiled at 2022-06-30 15:06:56 commit 0 last mr )

+ Non-SSL connection (SSL connection is recommended when requiring high-security)

+ Type "help" for help.

+

+ Uqbar=# CREATE TABLE warehouse_t1

+ (

+ W_WAREHOUSE_SK INTEGER NOT NULL,

+ W_WAREHOUSE_ID CHAR(16) NOT NULL,

+ W_WAREHOUSE_NAME VARCHAR(20) ,

+ W_WAREHOUSE_SQ_FT INTEGER Uqbar-# ,

+ W_STREET_NUMBER CHAR(10) ,

+ W_STREET_NAME VARCHAR(60) ,

+ W_STREET_TYPE CHAR(15) ,

+ W_Uqbar(# SUITE_NUMBER CHAR(10) ,

+ W_CITY VARCHAR(60) ,

+ W_COUNTY VARCHAR(30) ,

+ W_STATE CHAR(2) Uqbar(# ,

+ W_ZIP CHAR(10) ,

+ W_COUNTRY VARCHAR(20) Uqbar(# ,

+ W_GMT_OFFSET DECIMAL(5,2)

+ );

+ CREATE TABLE

+ Uqbar=#

+ ```

+

+5. 创建指定实例的增量备份。

+

+ **注意**:创建增量备份前,需在postgresql.conf中手动添加参数“enable_cbm_tracking = on”,并重启数据库确保参数生效。

+

+ ```bash

+ [ommdoc@hostname]$ gs_probackup backup -B /opt/uqbar/backup_dir --instance instance1 -b PTRACK

+ INFO: Backup start, gs_probackup version: 2.4.2, instance: instance1, backup ID: RGOZKI, backup mode: PTRACK, wal mode: STREAM, remote: false, compress-algorithm: none, compress-level: 1

+ LOG: Backup destination is initialized

+ LOG: This openGauss instance was initialized with data block checksums. Data block corruption will be detected

+ LOG: Database backup start

+ LOG: Latest valid FULL backup: RGOZF6

+ INFO: Parent backup: RGOZF6

+ LOG: started streaming WAL at 0/CC000000 (timeline 1)

+ INFO: Cannot parse path "base"

+ [2022-08-16 13:07:30]: check identify system success

+ [2022-08-16 13:07:30]: send START_REPLICATION 0/CC000000 success

+ [2022-08-16 13:07:30]: keepalive message is received

+ [2022-08-16 13:07:30]: keepalive message is received

+ INFO: PGDATA size: 1320MB

+ LOG: Current tli: 1

+ LOG: Parent start_lsn: 0/CA000028

+ LOG: start_lsn: 0/CC000028

+ INFO: Extracting pagemap of changed blocks

+ INFO: change bitmap start lsn location is 0/CA000028

+ INFO: change bitmap end lsn location is 00000000/CC000028

+ INFO: Pagemap successfully extracted, time elapsed: 0 sec

+ INFO: Start transferring data files

+ LOG: Creating page header map "/opt/uqbar/backup_dir/backups/instance1/RGOZKI/page_header_map"

+ INFO: Data files are transferred, time elapsed: 0

+ INFO: wait for pg_stop_backup()

+ INFO: pg_stop backup() successfully executed

+ LOG: stop_lsn: 0/CC0001E8

+ LOG: Looking for LSN 0/CC0001E8 in segment: 0000000100000000000000CC

+ LOG: Found WAL segment: /opt/uqbar/backup_dir/backups/instance1/RGOZKI/database/pg_xlog/0000000100000000000000CC

+ LOG: Thread [0]: Opening WAL segment "/opt/uqbar/backup_dir/backups/instance1/RGOZKI/database/pg_xlog/0000000100000000000000CC"

+ LOG: Found LSN: 0/CC0001E8

+ LOG: finished streaming WAL at 0/CD000000 (timeline 1)

+ LOG: Getting the Recovery Time from WAL

+ LOG: Thread [0]: Opening WAL segment "/opt/uqbar/backup_dir/backups/instance1/RGOZKI/database/pg_xlog/0000000100000000000000CC"

+ INFO: Syncing backup files to disk

+ INFO: Backup files are synced, time elapsed: 0

+ INFO: Validating backup RGOZKI

+ INFO: Backup RGOZKI data files are valid

+ INFO: Backup RGOZKI resident size: 273MB

+ INFO: Backup RGOZKI completed

+ ```

+

+6. 删除数据库目录。

+

+ ```bash

+ [ommdoc@hostname]$ gs_ctl stop -D /opt/uqbar/data

+ [2022-08-16 13:27:04.642][766772][][gs_ctl]: gs_ctl stopped ,datadir is /opt/uqbar/data

+ waiting for server to shut down.............. done

+ server stopped

+ [ommdoc@hostname]$ rm -rf /opt/uqbar/data

+ ```

+

+7. 恢复数据库。

+

+ ```bash

+ [ommdoc@uqbar-kernel-0003 data]$ gs_probackup restore -B /opt/uqbar/backup_dir --instance instance1 -D /opt/uqbar/data -i RGOZF6

+ LOG: Restore begin.

+ LOG: there is no file tablespace_map

+ LOG: check tablespace directories of backup RGOZF6

+ LOG: check external directories of backup RGOZF6

+ WARNING: Process 719280 which used backup RGOZF6 no longer exists

+ INFO: Validating backup RGOZF6

+ INFO: Backup RGOZF6 data files are valid

+ LOG: Thread [1]: Opening WAL segment "/opt/uqbar/backup_dir/backups/instance1/RGOZF6/database/pg_xlog/0000000100000000000000CA"

+ INFO: Backup RGOZF6 WAL segments are valid

+ INFO: Backup RGOZF6 is valid.

+ INFO: Restoring the database from backup at 2022-08-16 13:04:18+08

+ LOG: there is no file tablespace_map

+ LOG: Restore directories and symlinks...

+ INFO: Start restoring backup files. PGDATA size: 1336MB

+ LOG: Start thread 1

+ INFO: Backup files are restored. Transfered bytes: 1336MB, time elapsed: 0

+ INFO: Restore incremental ratio (less is better): 100% (1336MB/1336MB)

+ INFO: Syncing restored files to disk

+ INFO: Restored backup files are synced, time elapsed: 8s

+ INFO: Restore of backup RGOZF6 completed.

+ [ommdoc@hostname]$ gs_om -t restart

+ Stopping cluster.

+ =========================================

+ Successfully stopped cluster.

+ =========================================

+ End stop cluster.

+ Starting cluster.

+ =========================================

+ [SUCCESS] uqbar-kernel-0003

+ 2022-08-16 13:34:10.277 [unknown] [unknown] localhost 70371578937360 0[0:0#0] 0 [BACKEND] WARNING: could not create any HA TCP/IP sockets

+ 2022-08-16 13:34:10.277 [unknown] [unknown] localhost 70371578937360 0[0:0#0] 0 [BACKEND] WARNING: could not create any HA TCP/IP sockets

+ 2022-08-16 13:34:10.282 [unknown] [unknown] localhost 70371578937360 0[0:0#0] 0 [BACKEND] WARNING: No explicit IP is configured for listen_addresses GUC.

+ =========================================

+ Successfully started.

+ ```

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/cluster-management.md b/product/zh/docs-uqbar/v2.0/cluster-management.md

new file mode 100644

index 0000000000000000000000000000000000000000..c75858d80282ebb42321ff21a37605204ee98603

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/cluster-management.md

@@ -0,0 +1,130 @@

+---

+title: 集群管理

+summary: 集群管理

+author: Guo Huan

+date: 2022-11-24

+---

+

+# 集群管理

+

+Uqbar提供集群管理能力,支持主备高可用,当部分节点故障时,系统能够自动监测并切换到正常节点,保证系统可用性SLA达到99.95%。

+

+## 操作场景

+

+Uqbar在运行过程中,数据库管理员可能需要手工对数据库节点做主备切换。例如发现数据库节点主备failover后需要恢复原有的主备角色,或怀疑硬件故障需要手动进行主备切换。级联备机不能直接转换为主机,只能先通过switchover或者failover成为备机,然后再切换为主机。

+

+>  **说明:**

+>

+> - 主备切换为维护操作,确保Uqbar状态正常,所有业务结束后,再进行切换操作。

+> - 在开启极致RTO时,不支持级联备机。级联备机因为极致RTO开启情况下,备机不支持连接无法同步数据。

+

+

+

+## 操作步骤

+

+1. 以操作系统用户omm登录数据库任意节点,执行如下命令,查看主备情况。

+

+ ```bash

+ gs_om -t status --detail

+ ```

+

+2. 以操作系统用户omm登录准备切换为主节点的备节点,执行如下命令。

+

+ ```bash

+ gs_ctl switchover -D /home/omm/cluster/dn1/

+ ```

+

+ /home/omm/cluster/dn1/为备数据库节点的数据目录。

+

+ >  **须知:** 对于同一数据库,上一次主备切换未完成,不能执行下一次切换。对于业务正在操作时,发起switchover,可能主机的线程无法停止导致switchover显示超时,实际后台仍然在运行,等主机线程停止后,switchover即可完成。比如在主机删除一个大的分区表时,可能无法响应switchover发起的信号。

+

+3. switchover成功后,执行如下命令记录当前主备机器信息。

+

+ ```bash

+ gs_om -t refreshconf

+ ```

+

+

+

+## 示例

+

+将数据库节点备实例切换为主实例。

+

+1. 查询数据库状态。

+

+ ```bash

+ gs_om -t status --detail

+ [ Cluster State ]

+

+ cluster_state : Normal

+ redistributing : No

+ current_az : AZ_ALL

+

+ [ Datanode State ]

+

+ node node_ip port instance state

+ --------------------------------------------------------------------------------------------------

+ 1 pekpopgsci00235 10.244.62.204 5432 6001 /home/omm/cluster/dn1/ P Primary Normal

+ 2 pekpopgsci00238 10.244.61.81 5432 6002 /home/omm/cluster/dn1/ S Standby Normal

+ ```

+

+2. 登录备节点,进行主备切换。另外,switchover级联备机后,级联备机切换为备机,原备机将为级联备。

+

+ ```bash

+ gs_ctl switchover -D /home/omm/cluster/dn1/

+ [2020-06-17 14:28:01.730][24438][][gs_ctl]: gs_ctl switchover ,datadir is -D "/home/omm/cluster/dn1"

+ [2020-06-17 14:28:01.730][24438][][gs_ctl]: switchover term (1)

+ [2020-06-17 14:28:01.768][24438][][gs_ctl]: waiting for server to switchover............

+ [2020-06-17 14:28:11.175][24438][][gs_ctl]: done

+ [2020-06-17 14:28:11.175][24438][][gs_ctl]: switchover completed (/home/omm/cluster/dn1)

+ ```

+

+3. 保存数据库主备机器信息。

+

+ ```bash

+ gs_om -t refreshconf

+ Generating dynamic configuration file for all nodes.

+ Successfully generated dynamic configuration file.

+ ```

+

+

+

+## 异常处理

+

+异常判断标准如下:

+

+- 业务压力下,主备实例切换时间长,这种情况不需要处理。

+

+- 其他备机正在build的情况下,主机需要发送日志到备机后,才能降备,导致主备切换时间长。这种情况不需要处理,但应尽量避免build过程中进行主备切换。

+

+- 切换过程中,因网络故障、磁盘满等原因造成主备实例连接断开,出现双主现象时,此时请参考如下步骤修复。

+

+ >  **警告:** 出现双主状态后,请按如下步骤恢复成正常的主备状态。否则可能会造成数据丢失。

+

+1. 执行以下命令查询数据库当前的实例状态。

+

+ ```bash

+ gs_om -t status --detail

+ ```

+

+ 若查询结果显示两个实例的状态都为Primary,这种状态为异常状态。

+

+2. 确定降为备机的节点,在节点上执行如下命令关闭服务。

+

+ ```bash

+ gs_ctl stop -D /home/omm/cluster/dn1/

+ ```

+

+3. 执行以下命令,以standby模式启动备节点。

+

+ ```bash

+ gs_ctl start -D /home/omm/cluster/dn1/ -M standby

+ ```

+

+4. 保存数据库主备机器信息。

+

+ ```bash

+ gs_om -t refreshconf

+ ```

+

+5. 查看数据库状态,确认实例状态恢复。

diff --git a/product/zh/docs-uqbar/v2.0/continuous-aggregation.md b/product/zh/docs-uqbar/v2.0/continuous-aggregation.md

new file mode 100644

index 0000000000000000000000000000000000000000..4e36a56fc810ec0b4e05c2057725878527b6f97f

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/continuous-aggregation.md

@@ -0,0 +1,16 @@

+---

+title: 持续聚合

+summary: 持续聚合

+author: Guo Huan

+date: 2022-11x

+---

+

+# 持续聚合

+

+持续聚合(Continuous Aggregation)用于预先计算和聚合数据。持续聚合功能通过定义和调度周期性运行的查询,在数据库上生成聚合结果,并将其存储在一个时序表中。

+

+持续聚合的主要作用包括:

+

+- 实时聚合:通过后台计算聚合结果,使得查询可以立即获取到预先计算好的聚合数据,从而无需每次查询进行全量计算,大大提高了查询性能,并减少查询响应时间。

+- 数据降采样:持续聚合可以将高分辨率的时间序列数据降采样为较低分辨率的聚合数据。通过定义适当的时间间隔和聚合函数,可以将数据的频率降低,减少存储成本,提升查询效率。

+- 数据摘要:通过选取合适的聚合函数,如SUM、AVG、MIN、MAX等,可以生成数据的摘要信息。这些预先计算的摘要信息对于生成报告,或快速检索聚合数据非常有用,并且无需执行复杂的计算。

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-compression.md b/product/zh/docs-uqbar/v2.0/data-compression.md

new file mode 100644

index 0000000000000000000000000000000000000000..0146148a157fbaab0a482bb9b63e144e1fd1a9df

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-compression.md

@@ -0,0 +1,102 @@

+---

+title: 数据压缩

+summary: 数据压缩

+author: Zhang Cuiping

+date: 2022-11-22

+---

+

+# 数据压缩

+

+Uqbar时序数据库支持自动和手动压缩数据,以减少数据存储成本并提升查找效率。

+

+## 自动压缩

+

+后台按照设定的压缩延迟时间,自动对时序数据执行压缩,以节省存储空间。压缩的时间延迟可以通过 guc 参数 uqbar.timeseries_compression_delay 设置。

+

+### 语法格式

+

+自动压缩会根据设定的延迟自动触发,无需用户执行。

+

+### 注意事项

+

+- 压缩以 chunkgroup 为粒度进行,即一个 chunkgroup 内的所有 chunk 一起执行压缩操作。

+- 达到设置的压缩间隔后,数据压缩还需要满足以下条件:

+ - chunkgroup 的结束时间早于当前系统时间

+ - chunkgroup 内超过 uqbar.timeseries_compression_delay 的间隔没有数据写入

+ - 当前版本压缩成功后, chunkgroup 不支持再写入数据

+

+### 示例

+

+假设前置条件:chunkGroupDuration = 1 week,假设当前时间为2022-7-7 09:55:00

+

+1. 设置自动压缩延迟为 1 min,即 uqbar.timeseries_compression_delay = 60;

+

+2. 写入数据,保证分片内的所有数据都小于当前时间;

+

+ ```sql

+ INSERT INTO weather SELECT '2022-07-01 00:00:00'::timestamp, 'beijing', 'park', generate_series(1, 2000);

+ ```

+

+3. 查看chunk属性,找到建立的分片;

+

+ ```sql

+ SELECT * FROM timeseries_catalog.tschunk;

+ ```

+

+4. 两分钟以后再次查看chunk属性,确认其是否已经被压缩。

+

+## 手动压缩

+

+支持用户手动触发压缩,用户可以通过执行压缩命令,对时序表或时序表内的某个chunkgroup进行压缩。

+

+### 语法格式

+

+```sql

+COMPRESS TIMESERIES table_name [ PARTITION chunkgroupname ]

+```

+

+### 注意事项

+

+- 当前版本不支持对压缩后的chunkgroup再写入数据

+- 不指定 Partition 参数表示对时序表所有的 chunkgroup 执行压缩;指定 Partition 会对指定的 chunkgroup 执行压缩

+

+### 示例

+

+```sql

+Uqbar=# COMPRESS TIMESERIES weather PARTITION chunkgroup_1;

+COMPRESSED

+Uqbar=# COMPRESS TIMESERIES weather;

+COMPRESSED

+```

+

+## 压缩率视图

+

+系统内置 timeseries_views.compression_table 和 timeseries_views.compression_chunkgroup 两个视图,可以按照表和chunkgroup维度展示压缩前后的数据量、压缩率等数据。关于这两个视图的详细信息,参考[timeseries_views.compression_table](./timeseries-views/timeseries_views.compression_table.md)、[timeseries_views.compression_chunkgroup](./timeseries-views/timeseries_views.compression_chunkgroup.md)。

+

+### 语法格式

+

+```sql

+SELECT * FROM timeseries_views.compression_table;

+SELECT * FROM timeseries_views.compression_chunkgroup;

+```

+

+### 示例

+

+```sql

+--查看时序表weather的压缩率

+Uqbar=# SELECT tablename, before_compression_size, after_compression_size, compression_rate FROM timeseries_views.compression_table WHERE tablename = 'weather';

+ tablename | before_compression_size | after_compression_size | compression_ratio

+------------------------+-------------------------+--------------------+------------

+ weather | 1746534 | 1483457 | 1.17

+

+(1 rows)

+

+--查看时序表weather的分片压缩率

+Uqbar=# SELECT tablename, chunkgroupname, before_compression_size, after_compression_size, compression_ratio FROM timeseries_views.compression_chunkgroup WHERE tablename = 'weather';

+ tablename | chunkgroupname | before_compression_size | after_compression_size | compression_ratio

+--------------------+--------------------+---------------- --------+---------------------+------------

+ weather | p_1_1 | 387564 | 328576 | 1.17

+ weather | p_1_2 | 417829 | 358273 | 1.16

+

+(2 rows)

+```

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-write-introduction.md b/product/zh/docs-uqbar/v2.0/data-write/data-write-introduction.md

new file mode 100644

index 0000000000000000000000000000000000000000..fce426d9902054935e5e5560246a07bff3e5b716

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-write-introduction.md

@@ -0,0 +1,15 @@

+---

+title: 时序数据写入

+summary: 时序数据写入

+author: zhang cuiping

+date: 2022-11-12

+---

+

+# 时序数据写入

+

+本节主要介绍时序表接入方式、时序表写入模型以及时序数据写入性能指标。

+

+Uqbar支持标准SQL写入时序表、支持通过驱动写入时序数据,也可从Kafka消费数据。Uqbar时序数据写入模型包括单值模型和多值模型、允许乱序写入和无时间值写入等三种。

+

++ **[时序数据接入方式](./data-writing-method/data-writing-method.md)**

++ **[时序数据写入模型](./data-writing-model/data-writing-model.md)**

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/Kafka-supported-for-importing-data-to-table.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/Kafka-supported-for-importing-data-to-table.md

new file mode 100644

index 0000000000000000000000000000000000000000..9505f4f27769359dd53e2d95a63111291a649b01

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/Kafka-supported-for-importing-data-to-table.md

@@ -0,0 +1,237 @@

+---

+title: 支持从Kafka写入时序表

+summary: 支持从Kafka写入时序表

+author: Zhang Cuiping

+date: 2022-11-12

+---

+

+# 支持从Kafka写入时序表

+

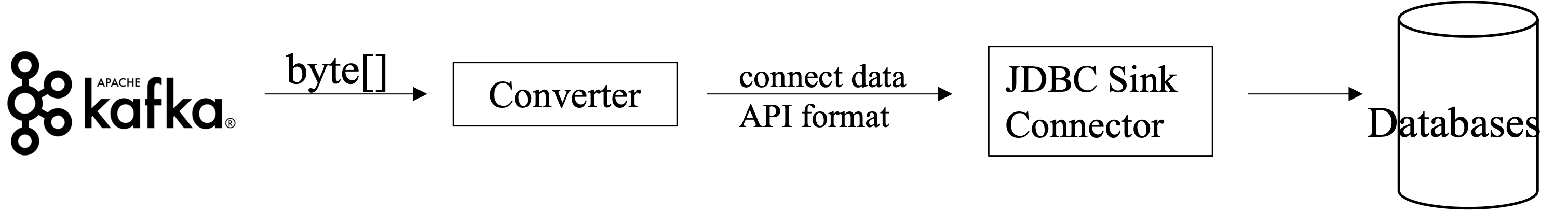

+传感器或监控数据支持从Kafka写入时序表。Kafka和Uqbar可通过Kafka JDBC Connector进行连接。该连接器负责从Kafka读取数据,然后将消息中的SQL发送到Uqbar执行并记录失败消费结果,维护消息消费位置。向数据库插入数据需要使用批量插入模式。

+

+

+

+## 安装流程

+

+### 下载Kafka

+

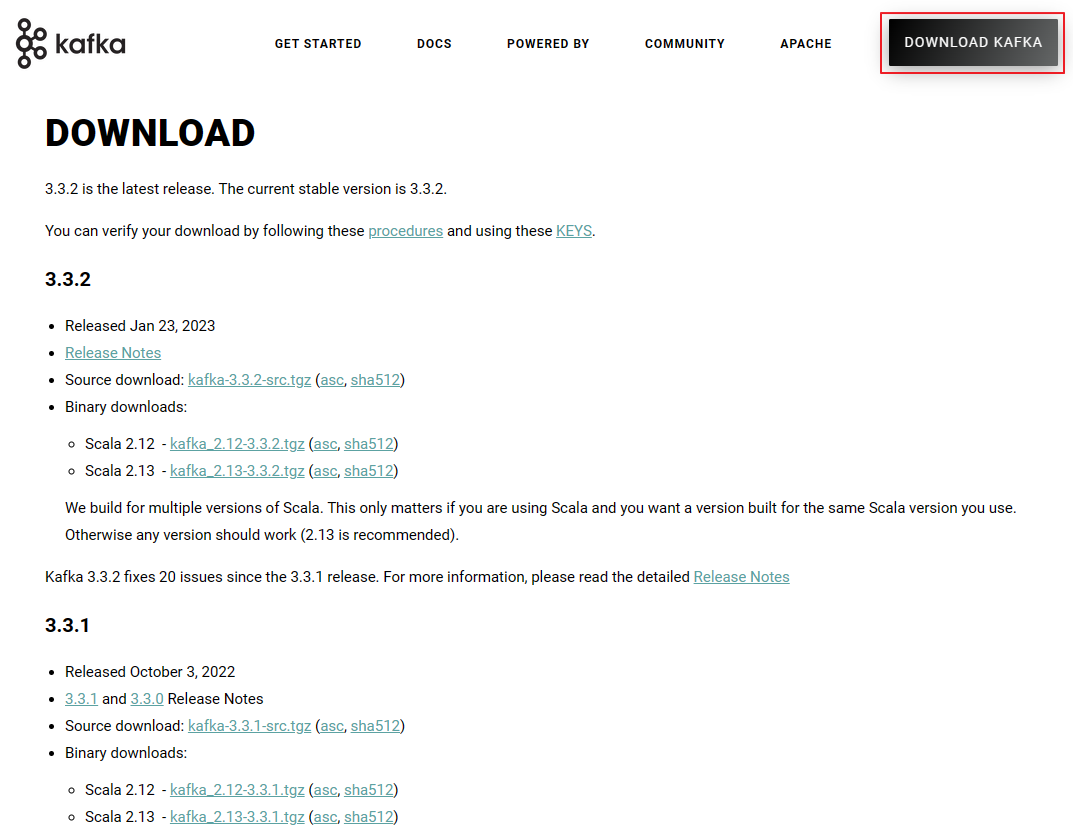

+访问 [Kafka官网](https://kafka.apache.org/downloads) 下载Kafka软件包,下载完成后解压。

+

+

+

+### 下载数据库驱动

+

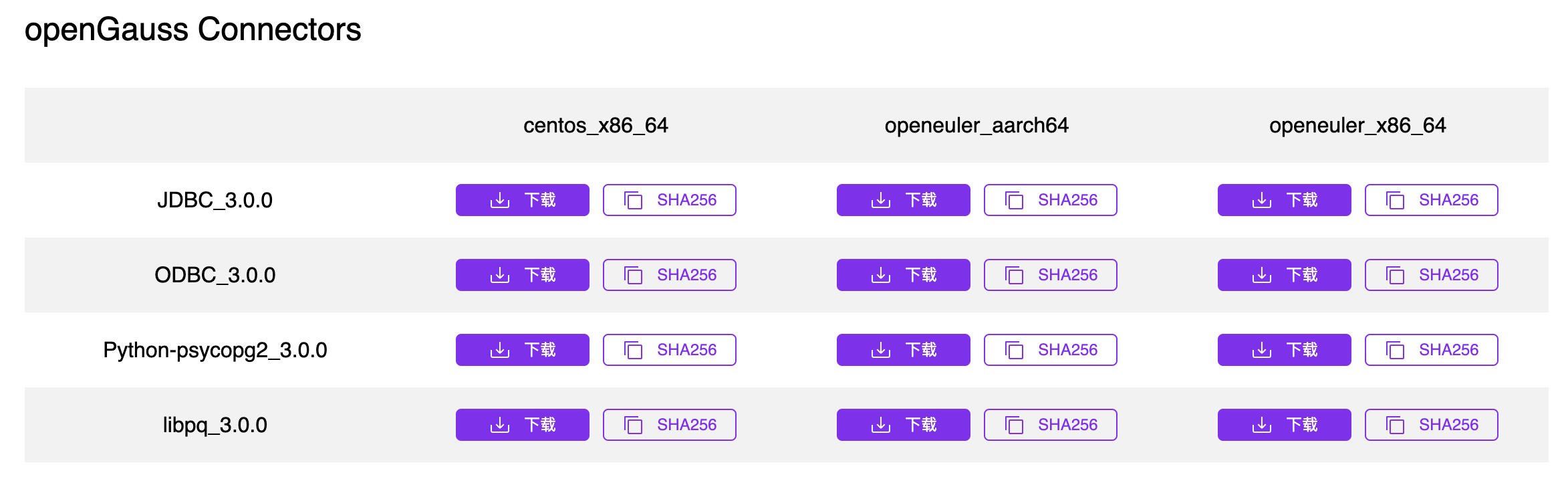

+下载对应数据库的JDBC驱动,以openGauss为例。访问[openGauss官网](https://www.opengauss.org/zh/download/)下载对应操作系统的JDBC驱动。

+

+

+

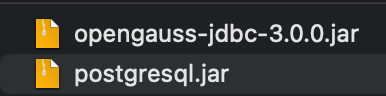

+下载完成后解压,得到相应的JAR包。

+

+

+

+复制JAR包到kafka路径下,例如/kafka_2.12-3.2.1/libs。

+

+### 下载Kafka JDBC Connector

+

+可通过访问[https://www.confluent.io/hub/confluentinc/kafka-connect-jdbc?_ga=2.140576818.1269349503.1660542741-1354758524.1659497119](https://www.confluent.io/hub/confluentinc/kafka-connect-jdbc?_ga=2.140576818.1269349503.1660542741-1354758524.1659497119),点击“Download”下载Kafka JDBC Connector。

+

+

+

+下载完成后解压到任意目录供后续使用。

+

+### 修改配置文件

+

+#### server.properties

+

+编辑kafka目录下的 `config/server.properties` 文件。

+

+```

+listeners=PLAINTEXT://0.0.0.0:9092

+advertised.listeners=PLAINTEXT://your.host.name:9092

+```

+

+修改或添加 `listeners=PLAINTEXT://0.0.0.0:9092` ,否则将无法监听外网请求。

+

+修改或添加 `advertised.listeners=PLAINTEXT://your.host.name:9092` ,*your.host.name*为本机的IP地址,否则外部网络将无法访问您的kafka。

+

+#### connect-distributed.properties

+

+编辑kafka目录下的 `config/connect-distributed.properties` 文件。

+

+```

+plugin.path=/usr/local/Cellar/confluentinc-kafka-connect-jdbc-10.5.2

+```

+

+`plugin.path`存放confluentinc-kafka-connect-jdbc文件夹的位置。如`plugin.path=/usr/local/Cellar/confluentinc-kafka-connect-jdbc-10.5.2`。

+

+## 启动Kafka

+

+1. 打开cmd/terminal并进入kafka目录,例如/kafka_2.12-3.2.1。

+

+ ```

+ cd /usr/local/Cellar/kafka_2.12-3.2.1

+ ```

+

+2. 启动zookeeper。

+

+ ```

+ sh bin/zookeeper-server-start.sh config/zookeeper.properties

+ ```

+

+3. 启动Kafka。

+

+ ```

+ sh bin/kafka-server-start.sh config/server.properties

+ ```

+

+4. 输入jps查看zookeeper和kafka启动情况。

+

+ ```

+ 81243 QuorumPeerMain #Zookeeper

+ 30701 Launcher

+ 81598 Kafka # Kafka

+ ```

+

+5. 启动Kafka Connect Worker。

+

+ ```bash

+ sh bin/connect-distributed.sh config/connect-distributed.properties

+ ```

+

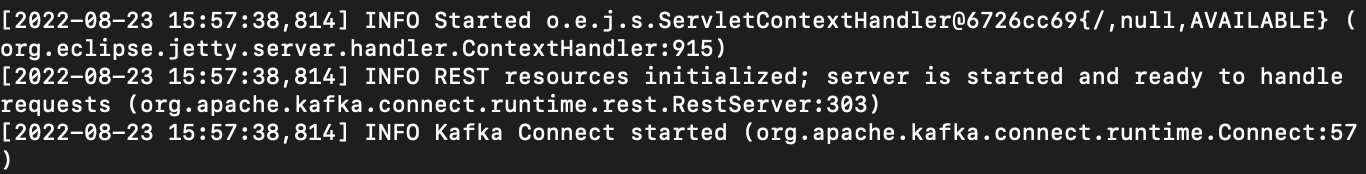

+ 如果显示如下回显信息,表示启动成功。

+

+

+

+ 通过jps可以查看到ConnectDistributed进程运行。

+

+ ```bash

+ 83931 ConnectDistributed

+ ```

+

+6. 启动JDBC Connector。

+

+ - 方式一:启动JDBC Connector

+

+ 通过终端或cmd 启动JDBC Connector。

+

+ ```

+ curl -X POST http://localhost:8083/connectors -H "Content-Type: application/json" -d '{

+ "name":"connector-name",

+ "config":{

+ "connector.class":"io.confluent.connect.jdbc.JdbcSinkConnector",

+ "connection.url":"jdbc:opengauss://localhost:15432/OpengaussDB",

+ "connection.user":"user",

+ "connection.password":"password",

+ "topics":"test_topic",

+ "insert.mode": "insert",

+ "table.name.format":"table_name_${topic}",

+ "auto.create":true,

+ "dialect.name": "PostgreSqlDatabaseDialect"

+ }

+ }'

+ ```

+

+ - 方式二:创建json文件配置 JDBC Connector。

+

+ 创建名为`test.json`的json文件,内容如下:

+

+ ```

+ {

+ "name":"connector-name",

+ "config":{

+ "connector.class":"io.confluent.connect.jdbc.JdbcSinkConnector",

+ "connection.url":"jdbc:opengauss://localhost:15432/OpengaussDB",

+ "connection.user":"user",

+ "connection.password":"password",

+ "topics":"test_topic",

+ "insert.mode": "insert",

+ "table.name.format":"table_name_${topic}",

+ "auto.create":true,

+ "dialect.name": "PostgreSqlDatabaseDialect"

+ }

+ }

+ ```

+

+ 在终端或cmd启动Kafka。

+

+ ```

+ curl -X POST http://localhost:8083/connectors -H "Content-Type: application/json" -d @test.json

+ ```

+

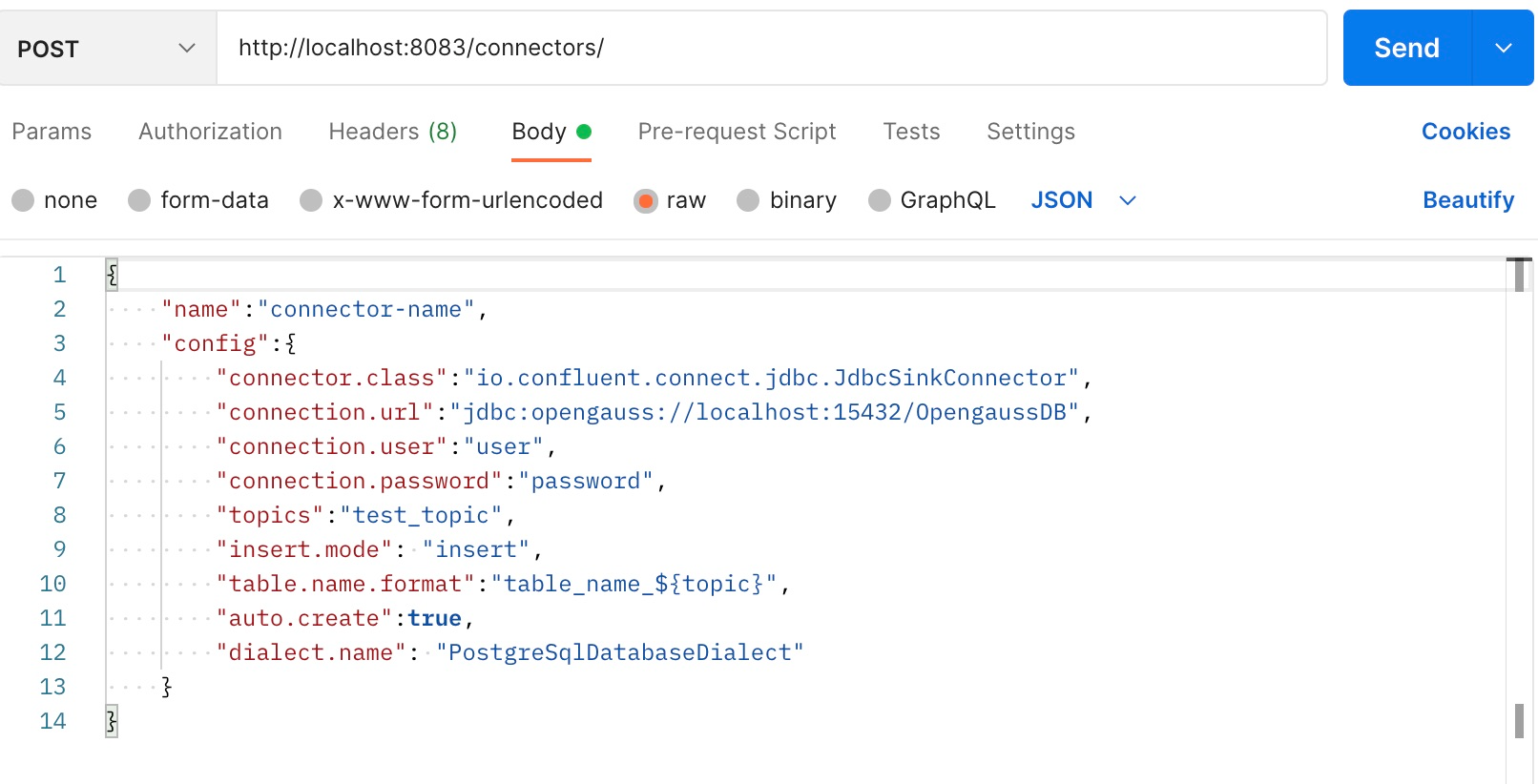

+ - 方式三:使用Postman等接口测试工具

+

+

+

+ 设置好参数后发送post请求。

+

+ 显示类似如下的消息表示Connector启动成功。

+

+ ```

+ {

+ "name": "connector-name",

+ "config": {

+ "connector.class": "io.confluent.connect.jdbc.JdbcSinkConnector",

+ "connection.url": "jdbc:opengauss://localhost:15432/sink",

+ "connection.user": "user1",

+ "connection.password": "Enmo@123",

+ "topics": "test",

+ "insert.mode": "insert",

+ "table.name.format": "tableName_${topic}",

+ "auto.create": "true",

+ "dialect.name": "PostgreSqlDatabaseDialect",

+ "name": "connector-name"

+ },

+ "tasks": [],

+ "type": "sink"

+ }

+ ```

+

+## 数据写入示例

+

+一个JDBC Connector,至少需要包含如下参数:

+

+```

+"connector.class":"io.confluent.connect.jdbc.JdbcSinkConnector",

+"connection.url":"jdbc:opengauss://localhost:15432/OpengaussDB",

+"connection.user":"user",

+"connection.password":"password",

+"topics":"test",

+"table.name.format":"tableName"

+```

+

+假设要写入数据库的数据表结构以及配置如下:

+

+```

+CREATE TABLE "test" (

+ "id" INT NOT NULL,

+ "longitude" REAL NULL,

+ "latitude" REAL NULL,

+ "temperature" REAL NULL,

+ "humidity" REAL NULL,

+ "time" TIME NULL,

+ "string_time" TEXT NULL,

+ "randomString" TEXT NULL

+);

+```

+

+```

+curl -X POST http://localhost:8083/connectors -H "Content-Type:application/json" -d '{

+ "name":"connector-name",

+ "config":{

+ "connector.class":"io.confluent.connect.jdbc.JdbcSinkConnector",

+ "connection.url":"jdbc:opengauss://localhost:15432/sink",

+ "connection.user":"user1",

+ "connection.password":"password",

+ "topics":"topic",

+ "table.name.format":"test"

+ }

+}'

+```

+

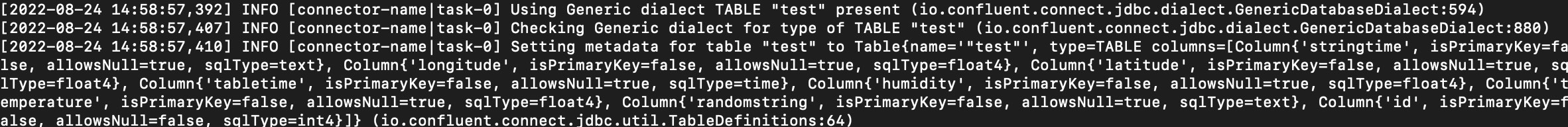

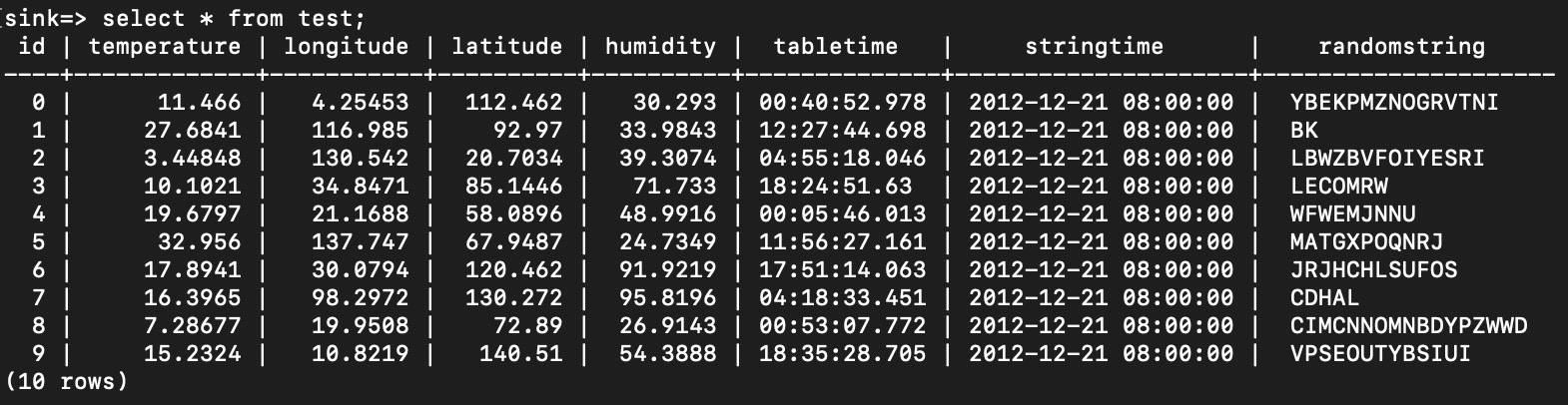

+在source端发送数据,启动JDBC Connector。如果终端或cmd显示如下信息,表示Kafka启动成功。

+

+

+

+在数据库中查询,可以发现数据已保存到表中。

+

+

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/SQL-supported-for-importing-data-to-table.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/SQL-supported-for-importing-data-to-table.md

new file mode 100644

index 0000000000000000000000000000000000000000..6729ab63cf0b592ad0695bd146a89692069a5e8f

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/SQL-supported-for-importing-data-to-table.md

@@ -0,0 +1,44 @@

+---

+title: 支持标准SQL写入时序表

+summary: 支持标准SQL写入时序表

+author: Zhang Cuiping

+date: 2022-11-12

+---

+

+# 支持标准SQL写入时序表

+

+传感器或监控数据支持使用标准SQL写入时序表。一次可插入单条或多条数据。写入数据前请先创建时序表,或确保系统已存在时序表。

+

+## 注意事项

+

+- 支持不带时间值插入。

+- 支持乱序插入(本版本支持未压缩chunk的乱序写入)。

+- tstime列不能写入NULL值。

+- tstag不能写入NULL值。

+

+## 语法格式

+

+- 插入单条数据

+

+ ```sql

+ INSERT INTO table_name[(targelist)] VALUES(value_list);

+ ```

+

+- 插入多条数据

+

+ ```sql

+ INSERT INTO table_name[(targelist)] VALUES(value_list)[, (value_list)]...;

+ ```

+

+## 示例

+

+```sql

+MogDB=# INSERT INTO weather(time, city, location, temperature) VALUES('2022-07-06 00:00:00','beijing', 'gongyuan', 29.1);

+INSERT 0 1

+MogDB=# INSERT INTO weather(time, city, location, temperature) VALUES('2022-07-06 00:00:00','beijing', 'chaoyang', 29.1), ('2022-7-6 00:00:00','shanghao', 'gongyuan', 29.2);

+INSERT 0 2

+```

+

+## 相关页面

+

+[INSERT](../../uqbar-sql-syntax/INSERT.md)、[COPY](../../uqbar-sql-syntax/COPY.md)

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/data-writing-method.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/data-writing-method.md

new file mode 100644

index 0000000000000000000000000000000000000000..98b78347db6166dab67adf7f0b0010350ca05568

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/data-writing-method.md

@@ -0,0 +1,12 @@

+---

+title: 时序数据接入方式

+summary: 时序数据接入方式

+author: Guo Huan

+date: 2023-06-08

+---

+

+# 时序数据接入方式

+

++ **[支持标准SQL写入时序表](./SQL-supported-for-importing-data-to-table.md)**

++ **[通过驱动写入时序数据](./driver-supported-for-importing-data-to-table.md)**

++ **[从Kafka消费数据](./Kafka-supported-for-importing-data-to-table.md)**

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/driver-supported-for-importing-data-to-table.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/driver-supported-for-importing-data-to-table.md

new file mode 100644

index 0000000000000000000000000000000000000000..c51aaa9a35fda35b64d4263864efdb0d472e3762

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-method/driver-supported-for-importing-data-to-table.md

@@ -0,0 +1,73 @@

+---

+title: 支持驱动写入时序表

+summary: 支持驱动写入时序表

+author: Zhang Cuiping

+date: 2022-11-12

+---

+

+# 支持驱动写入时序表

+

+传感器或监控数据支持使用Libpq、JDBC、ODBC、GO以及Python驱动使用COPY语法写入时序表。一次可插入单条或多条数据。写入数据前请先创建时序表,或确保系统已存在时序表。

+

+## 注意事项

+

+- 支持Libpq、JDBC和GO的prepare和COPY语义,向时序表插入数据。

+- 支持ODBC的prepare语义,向时序表插入数据。

+

+## 语法格式

+

+- Libpq 驱动

+

+ ```

+ PQprepare

+ PQexecPrepared

+ PQputCopyData

+ ```

+

+- JDBC 驱动

+

+ ```sql

+ java.sql.PreparedStatement

+ CopyManager

+ ```

+

+- ODBC 驱动

+

+ ```

+ SQLPrepare

+ SQLExecute

+ --不支持COPY

+ ```

+

+- GO 驱动

+

+ ```

+ Prepare()

+ Exec()

+ ```

+

+## 示例

+

+- JDBC prepare接口:[https://docs.mogdb.io/zh/mogdb/v3.0/5-java-sql-PreparedStatement](https://docs.mogdb.io/zh/mogdb/v3.0/5-java-sql-PreparedStatement)

+

+ JDBC prepare示例:[https://docs.mogdb.io/zh/mogdb/v3.0/7-running-sql-statements](https://docs.mogdb.io/zh/mogdb/v3.0/7-running-sql-statements)

+

+- JDBC COPY接口:[https://docs.mogdb.io/zh/mogdb/v3.0/14-CopyManager](https://docs.mogdb.io/zh/mogdb/v3.0/14-CopyManager)

+

+ JDBC COPY示例(非官方):[https://blog.csdn.net/ifenggege/article/details/108905808](https://blog.csdn.net/ifenggege/article/details/108905808)

+

+- Libpq prepare接口:[https://docs.mogdb.io/zh/mogdb/v3.0/11-PQprepare](https://docs.mogdb.io/zh/mogdb/v3.0/11-PQprepare)

+

+ Libpq prepare示例(非官方):[https://www.cnblogs.com/gaojian/p/3140491.html](https://www.cnblogs.com/gaojian/p/3140491.html)

+

+- Libpq COPY接口(非官方):[http://www.postgres.cn/docs/10/libpq-copy.html](http://www.postgres.cn/docs/10/libpq-copy.html)

+

+ Libpq COPY示例(非官方):[https://blog.csdn.net/liufeng1980423/article/details/108254469](https://blog.csdn.net/liufeng1980423/article/details/108254469)

+

+- GO prepare示例(非官方):[https://vimsky.com/examples/usage/golang_database_sql_DB_Prepare.html](https://vimsky.com/examples/usage/golang_database_sql_DB_Prepare.html)

+

+- GO COPY示例(非官方):[https://pkg.go.dev/github.com/lib/pq#section-readme](https://pkg.go.dev/github.com/lib/pq#section-readme)

+

+## 相关页面

+

+[COPY](../../uqbar-sql-syntax/COPY.md)

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-imported-out-of-order.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-imported-out-of-order.md

new file mode 100644

index 0000000000000000000000000000000000000000..16152f719c8d6fa47a3d9d8dd6b5c747dffa379e

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-imported-out-of-order.md

@@ -0,0 +1,29 @@

+---

+title: 乱序写入

+summary: 乱序写入

+author: Zhang Cuiping

+date: 2021-11-23

+---

+

+# 乱序写入

+

+Uqbar支持数据乱序写入。通常情况下上报到Uqbar的数据是按照时间顺序有序排列的,也就是后写入的数据time列的值大于先写入的数据。但是由于各种原因,例如网络或者消息队列的问题,可能导致后写入的数据time列的值小于先写入的数据,这种现象称为乱序。时序数据库中的乱序,通常是针对同一个采集器而言,即相同标签集的数据。

+

+**说明**:Uqbar支持未压缩数据的乱序写入,暂不支持压缩后数据的乱序写入。

+

+## 语法格式

+

+```

+INSERT INTO table VALUES [, ...];

+```

+

+## 示例

+

+```sql

+Uqbar=# CREATE TIMESERIES TABLE weather(time timestamp TSTIME, city text TSTAG, location text TSTAG, temperature float) POLICY default_policy;

+CREATE TIMESERIES TABLE

+Uqbar=# INSERT INTO weather VALUES('2022-06-18 00:00:00', 'beijing', 'park', 36);

+INSERT 0 1

+Uqbar=# INSERT INTO weather VALUES('2022-06-17 12:00:00', 'beijing', 'park', 30);

+INSERT 0 1

+```

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-imported-without-the-time-field.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-imported-without-the-time-field.md

new file mode 100644

index 0000000000000000000000000000000000000000..1cab06f57b35a2f6c93848ed0dd81dae68a8e60b

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-imported-without-the-time-field.md

@@ -0,0 +1,25 @@

+---

+title: 无时间值写入

+summary: 无时间值写入

+author: Zhang Cuiping

+date: 2021-11-23

+---

+

+# 无时间值写入

+

+Uqbar支持无时间值的时序数据写入,对无时间值的时序数据以服务端系统时间作为time列的值。当插入语法中没有指定插入时间时,数据库使用插入时的数据库时间补录time列。

+

+默认timestamp的精度为ms(秒级单位小数点后6位),用户也可以使用如now()::timestamp(x)这样的语法指定小数点后保留几位。(timestamp(3) 表示小数点后保留3位)。

+

+## 语法格式

+

+```

+INSERT INTO table VALUES [, ...];

+```

+

+## 示例

+

+```sql

+Uqbar=# INSERT INTO weather(city, location, temperature) VALUES('beijing', 'chaoyang', 29.1);

+INSERT 0 1

+```

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-writing-model.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-writing-model.md

new file mode 100644

index 0000000000000000000000000000000000000000..87a24391a43001230309d1f596691b73a0522581

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/data-writing-model.md

@@ -0,0 +1,12 @@

+---

+title: 时序数据写入模型

+summary: 时序数写入模型

+author: Guo Huan

+date: 2023-06-08

+---

+

+# 时序数据写入模型

+

++ **[单值模型和多值模型](./single-field-and-multiple-field-model.md)**

++ **[乱序写入](./data-imported-out-of-order.md)**

++ **[无时间值写入](./data-imported-without-the-time-field.md)**

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/single-field-and-multiple-field-model.md b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/single-field-and-multiple-field-model.md

new file mode 100644

index 0000000000000000000000000000000000000000..945a1a01692716cce4858d87b7df36b0a1b9fa2f

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/data-write/data-writing-model/single-field-and-multiple-field-model.md

@@ -0,0 +1,51 @@

+---

+title: 单值模型和多值模型

+summary: 单值模型和多值模型

+author: Zhang Cuiping

+date: 2021-11-23

+---

+

+# 单值模型和多值模型

+

+Uqbar支持单值和多值模型写入。单值模型指创建时序表时,只有一个非TSTIME非TSTAG的字段列,多值模型指创建时序表时有多个非TSTIME非TSTAG的字段列。

+

+## 语法格式

+

+语法格式支持[INSERT](../../uqbar-sql-syntax/INSERT.md)和[COPY](../../uqbar-sql-syntax/COPY.md)。

+

+```

+INSERT INTO table_name[(targelist)] VALUES(value_list)[, (value_list)]...;

+```

+

+```

+COPY table_name [ ( column_name [, ...] ) ]

+ FROM { 'filename' | STDIN }

+ [ [ USING ] DELIMITERS 'delimiters' ]

+ [ WITHOUT ESCAPING ]

+ [ LOG ERRORS ]

+ [ REJECT LIMIT 'limit' ]

+ [ WITH ( option [, ...] ) ]

+ | copy_option

+ | TRANSFORM ( { column_name [ data_type ] [ AS transform_expr ] } [, ...] )

+ | FIXED FORMATTER ( { column_name( offset, length ) } [, ...] ) [ ( option [, ...] ) | copy_option [ ...] ] ];

+```

+

+## 示例

+

+- 单值模型表创建和插入

+

+ ```sql

+ MogDB=# CREATE TIMESERIES TABLE weather(time timestamp TSTIME, city text TSTAG, location text TSTAG, temperature float) POLICY default_policy;

+ CREATE TIMESERIES TABLE

+ MogDB=# INSERT INTO weather VALUES('2022-06-18 00:00:00', 'beijing', 'park', 36);

+ INSERT 0 1

+ ```

+

+- 多值模型表创建和插入

+

+ ```sql

+ MogDB=# CREATE TIMESERIES TABLE weather(time timestamp TSTIME, city text TSTAG, location text TSTAG, temperature float, humidity float) POLICY default_policy;

+ CREATE TIMESERIES TABLE

+ MogDB=# INSERT INTO weather VALUES('2022-06-18 00:00:00', 'beijing', 'park', 36, 2.1);

+ INSERT 0 1

+ ```

\ No newline at end of file

diff --git a/product/zh/docs-uqbar/v2.0/expired-deletion.md b/product/zh/docs-uqbar/v2.0/expired-deletion.md

new file mode 100644

index 0000000000000000000000000000000000000000..6d8653077292ce46fa5a3cea3cc121f7fe19ec0a

--- /dev/null

+++ b/product/zh/docs-uqbar/v2.0/expired-deletion.md

@@ -0,0 +1,43 @@

+---

+title: 数据删除

+summary: 数据删除

+author: Guo Huan

+date: 2022-11-23

+---

+

+# 数据删除

+

+时序数据通常具有一定的时效性,数据操作基本集中在最新的数据上。用户可以通过配置数据保留策略,自动删除超过保留期限的数据。另外,用户也可以通过调用删除接口手动执行数据删除。

+

+

+

+## 自动删除数据

+

+在创建时序表的时候确定了时序表的数据保留策略,当时序表内数据所在的 chunkgroup 的右边界早于当前时间减去数据保留时长,系统会后台自动删除整个chunkgroup 内的数据。

+

+

+

+## 手动删除数据

+

+通过调用函数进行手动数据删除。

+

+### 示例

+

+```sql

+SELECT * FROM timeseries_catalog.drop_ts_outdate_cg(‘weather’, now());

+SELECT * FROM timeseries_catalog.drop_ts_outdate_cg(‘public.weather’, now()+ ‘1 h’::interval);

+NOTICE: timeseries table weather outdate boundary is 2022-10-31 12:58:01.641916+08

+NOTICE: chunkgroup 24773 boundary is 2022-07-27 04:00:00+08

+NOTICE: chunkgroup 24773 with boundary(2022-07-27 04:00:00+08) is out of date.

+NOTICE: drop chunkgroup 24773 of rel 24760

+NOTICE: chunkgroup 24780 boundary is 2025-10-18 09:00:00+08

+NOTICE: chunkgroup 24787 boundary is 2025-10-18 11:00:00+08

+NOTICE: chunkgroup 24794 boundary is 2025-10-18 12:00:00+08

+NOTICE: chunkgroup 24801 boundary is 2030-07-28 06:00:00+08

+```

+

+手动删除函数的第一个参数用于指定时序表,第二个参数指定触发数据删除的时间。调用过期删除函数,会立即触发一次自动删除动作,自动删除以函数的第二个参数作为当前系统时间进行数据过期检查。

+

+函数执行时会输出提示信息展示时序表每个chunkgroup的过期边界,还会输出信息展示被删除的chunkgroup信息。

+

+如果时序表中数据设置的保留策略是永久保留,无法通过调用删除函数进行手动删除。

diff --git a/product/zh/docs-uqbar/v2.0/glossary.md b/product/zh/docs-uqbar/v2.0/glossary.md

new file mode 100644

index 0000000000000000000000000000000000000000..106b9f16ae39639eb5a1a009e337fb3a435e1e52

--- /dev/null